Արհեստական բանականություն

| Արհեստական բանականություն |

|---|

| Հիմնական նպատակներ |

| Մոտեցումներ |

| Փիլիսոփայություն |

| Պատմություն |

| Տեխնոլոգիա |

| Բառարան |

Արհեստական բանականություն կամ արհեստական ինտելեկտ (երբեմն նաև մեքենայական ինտելեկտ, անգլ.՝ artificial intelligence, AI), ի տարբերություն մարդուն և կենդանիներին հատուկ «բնական» բանականության, մեքենայի կողմից ցուցադրվող բանականություն։ Ինֆորմատիկայում ԱԻ հետազոտությունը սահմանվում է որպես «խելացի գործակալի» հետազոտություն՝ ցանկացած սարք, որն ընկալում է իր շրջակայքը և ձեռնարկում է գործողություններ, որոնք առավելագույնի են հասցնում հաջողությամբ նպատակին հասնելու նրա հնարավորությունները։ Կոպիտ ասած, «արհեստական ինտելեկտ» տերմինը կիրառվում է, երբ մեքենան իրականացնում է «ճանաչողական» գործառույթներ, ինչպես օրինակ «սովորելը» և «խնդիր լուծելը», որոնց մարդիկ սովորաբար ասոցացնում են «խելքի» հետ [1]։

Արհեստական ինտելեկտի հստակ սահմանները վիճարկելի են․ մեքենաները հետզհետե ավելի բարդ խնդիրներ լուծելու ունակ են դառնում և այն խնդիրները, որոնք նախկինում համարվում էին «ինտելեկտ» պահանջող, հաճախ տարանջատվում են «արհեստական ինտելեկտ» սահմանումից և համարվում զուտ ինժեներական խնդիրներ։ Ըստ այդմ, որոշ մասնագետներ գտնում են, որ «արհեստական ինտելեկտ է այն խնդիրը, որը դեռ չի լուծվել» (AI is whatever hasn't been done yet)[2]։ Օրինակ, գրանշանների օպտիկական ճանաչումը հաճախ արդեն չի դասակարգվում «արհեստական ինտելեկտի» խնդիրների շարքին և համարվում է «սովորական» տեխնոլոգիա[3]։ Արհեստական ինտելեկտի դասին վերագրվող և մեքենաների կողմից որոշակի հաջողությամբ իրականացվող ժամանակակից խնդիրներից են մարդկային խոսքի ճանաչումը, պատկերների ճանաչումը, բարձր մակարդակի ռազմավարական խաղեր խաղալը [4] (ինչպես շախմատը, պոկերը և Go խաղը)[5], ինքնավար (առանց վարորդի) ավտոմեքենաները, բովանդակության բաշխման ցանցերը և ռազմական սիմուլյացիաները։

Արհեստական բանականությունը որպես ակադեմիական ուղղություն ստեղծվել է 1956 թվականին և տարիների ընթացքում լավատեսության մի քանի ալիքներ է ունեցել[6],>[7] որոնց հետևել են հիասթափություն և ֆինանսավորման կորուստ (հայտնի որպես «արհեստական ինտելեկտի ձմեռ»)[8][9], այնուհետ նոր մոտեցումներ, հաջողություն և նորացված ֆինանսավորում[7][10]։ Իր պատմության մեծ մասի ընթացքում արհեստական ինտելեկտը բաժանվել է մի քանի ենթաճյուղերի, որոնք հաճախ հակասությունների մեջ են միմյանց հետ[11]։ Այդ տարաձայնությունները պայմանավորված են տեխնիկական նկատառումներով (օրինակ ռոբոտաշինություն թե՞ մեքենայական ուսուցում)[12], մեթոդաբանությամբ (տրամաբանական ինտելեկտ թե՞ արհեստական նեյրոնային ցանց) կամ ավելի խոր փիլիսոփայական խնդիրներով[13][14][15]։ Մոտեցումների տարբերությունները երբեմն պայմանավորված են նաև սոցիալական գործոննեով (կոնկրետ հաստատություններ կամ կոնկրետ հետազոտողների աշխատանքներ)[11]։

Արհեստական բանականության ավանդական խնդիրները (կամ նպատակները) հիմնականում նեղ և մասնավոր դեպքերի են վերաբերում․ այդ խնդիրների շարքում են՝ գիտելիքի ներկայացումը, ավտոմատացված պլանավորումը, մեքենայական ուսուցումը, բնական լեզվի մշակումը, մեքենայական ընկալումը, օբյեկտների տեղաշարժի ճանաչումը և փոխազդելու ունակությունը[12]։ «Ընդհանուր արհեստական ինտելեկտը», այսինքն բազմազան խնդիրների միաժամանակյա վերլուծությունը և լուծումը, ըստ որոշ մասնագետների, երկարաժամկետ նպատակների թվում է[16]։ Արհեստական ինտելեկտի մոտեցումները ներառում են վիճակագրական մեթոդներ, համակարգչային ինտելեկտ և ավանդական սիմվոլիկ արհեստական ինտելեկտ։ Օգտագործվում են շատ գործիքներ․ որոնում և մաթեմատիկական օպտիմիզացիա, արհեստական նեյրոնային ցանցեր և վիճակագրության և հավանականությունների տեսության վրա հիմնված մեթոդներ։ Արհեստական ինտելեկտի զարգացումը հիմնված հաշվողական գիտության, մաթեմատիկայի, լեզվաբանության, հոգեբանության, փիլիսոփայության, տրամաբանության, խաղերի տեսության և շատ այլ գիտական ուղղությունների վրա։

Ճյուղը հիմնվել է այն դրույթից ելնելով, որ մարդու բանականությունը «հնարավոր է ճշգրիտ նկարագրել, այնպես որ հնարավոր է մեքենա ստեղծել, որ այն նմանակի»[17]։ Սա բարձրացնում է մտքի բնույթի և մարդկային ինտելեկտով օժտված արհեստական էակների ստեղծման էթիկայի փիլիսոփոյական փաստարկները, որոնք խնդիրներ էին, որ ուսումնասիրվել են միֆերի, ֆանտաստիկայի և փիլիսոփայության մեջ անտիկ ժամանակներից ի վեր[18]։ Ոմանք արհեստական ինտելեկտի առաջընթացը դիտարկում են որպես վտանգ մարդկության հանդեպ[19]։ Մյուսները կարծում են, որ ի տարբերություն նախորդ տեխնոլոգիական հեղափոխությունների, կբերի զանգվածային գործազրկության[20]։

Քսանմեկերորդ դարում, հաշվարկային հզորության, տվյալների հսկայական քանակության և տեսական ընկալման բնագավառների զուգահեռ առաջընթացից հետո, արհեստական ինտելեկտի մեթոդները վերածնունդ ապրեցին, և ԱԻ մեթոդները տեխնոլոգիական ինդուստրիայի էական բաղկացուցիչը դարձան, օգնելով լուծել համակարգչային գիտության, մաթապահովման նախագծման և գործողությունների հետազոտման դժվար խնդիրները[10][21]։

Պատմություն

[խմբագրել | խմբագրել կոդը]Մտածելու ընդունակություն ունեցող արհեստական էակներ, որպես պատմություններ պատմող սարքեր, ներկայացվել են անտիկ ախարհում[22] և տարածված էին գեղարվեստական ժանրում, ինչպես Մերի Շելլիի Ֆրանկենշթեյն կամ Կարել Չապեկի Ռոսսոմի ունիվերսալ ռոբոտներ.[23] Այս կերպարները և նրանց ճակատագրերը բարձրացնում էին միևնույն խնդիրները, ինչ այժմ քննարկվում է արհեստական ինտելեկտի էթիկայում[18]։ Բանականության ուսումնասիրությունները սկսվել են անտիկ փիլիսոփաներից և մաթեմատիկոսներից։ Մաթեմատիկական տրամաբանության ուսումնասիրությունը հանգեցրեց Ալան Թյուրինգի հաշվարկների տեսությանը, որում ենթադրվում է, որ մեքենան «0» և «1» պարզ սիմվոլները խառնելու և վերադասավորելու օգնությամբ կարող է նմանակել կամայական իմաստալից մաթեմատիկական եզրակացություն։ Այս հասկացությունը, որ թվային համակարգիչները կարող են նմանակել ֆորմալ մտածողության կամայական պրոցես, հայտնի է որպես Չյորչ-Թյուրինդի թեզիս[24]։ Նեյրոգիտության, ինֆորմացիայի տեսության և կիբեռնետիկայի զուգահեռ զարգացումները հետազոտողներին ուղղորդեցին դիտարկել էլեկտրոնային ուղեղի ստեղծման հնարավորությունը։ Թյուրինգը ենթադրեց, որ եթե մարդը չի կարողանում տարբերել անձի և մեքենայի պատասխանները, ապա մեքենան կարելի է համարել “խելացի"[25]։ Որպես համընդհանուր ճանաչում ունեցող արհեստական ինտելեկտի աշխատանք կարելի է համարել 1943 թվականին Մակկալոկի և Փիթսի կողմից Թյուրինգի լրիվության համար ստեղծած "արհեստական նեյրոնները"։[26]

Արհեստական ինտելեկտի ճյուղը ծնվել է 1956 թվականին. Դարտմութի քոլեջի վորքշոփի ժամանակ[24]։ Մասնակիցները՝ Ալեն Նյուել (Կարնեգի Մելոն համալսարան), Հերբերտ Սայմոն (Կարնեգի Մելոն համալսարան), Ջոն Մակկարտի (Մասաչուսեթսի Տեխնոլոգիական ինստիտուտ), Մարվին Մինսկի (Մասաչուսեթսի Տեխնոլոգիական ինստիտուտ) և Արթուր Սամուել (IBM), դարձան արհեստական ինտելեկտի հիմնադիրներն ու հետազոտողները[27]։ Նրանք և նրանց ուսանողները ծրագրեր էին իրականացնում, որոնց մամուլը "ապշեցուցիչ" էր անվանում․[28] համակարգիչները յուրացնում էին շաշկու ռազմավարությունը (1954)[29] (և 1959 թվականին ըստ էության ավելի լավ էին խաղում, քան միջին ունակությունների տեր մարդը)[30], լուծում էին տեքստային խնդիրները հանրահաշվում,ապացուցում էին տրամաբանական թեորեմները (1956) և անգլերեն խոսում[31]։ 1960-ականների կեսերին, արհեստական ինտելեկտի հետազոտությունները մեծապես ֆինանսավորվում էին ԱՄՆ պաշտպանության նախարարության առաջատար հետազոտական նախագծերի գործակալության կողմից[32]։ Եվ աշխարհով մեկ լաբորատորիաներ հիմնվեցին[33]։ Արհեստական ինտելեկտի հիմնադիրները ապագայի նկատմամբ լավատես էին․ Հերբերտ Սայմոնը կանխատեսում էր, "քսան տարի անց մեքենաները կկարողանան կատարել մարդու կողմից կատարվող կամայական աշխատանք"։ Մարվին Մինսկին համաձայնել էր գրելով, "մի սերունդ անց ... 'արհեստական ինտելեկտի' ստեղծման պրոբլեմը էապես կլուծվի"[6]։

Նրանք չկարողացան գնահատել մնացած խնդիրների դժվարությունները։ Առաջընթացը դանդաղեց և 1974 թվականին, ի պատասխան Ջեյմս Լայթհիլլի քննադատությանը և ԱՄՆ-ի կոնգրեսի շարունակական ճնշումներին ֆինանսավորել ավելի արդյունավետ նախագծեր, թե ԱՄՆ և թե Բրիտանական կառավարությունները կտրեցին արհեստական ինտելեկտի հետազոտությունների ֆինանսավորումը։ Հաջորդ մի քանի տարիները հետագայում կոչվեցին «ԱԲ ձմեռ»[8] ժամանակաշրջան, երբ արհեստական ինտելեկտի ֆինանսավորում դժվար էր ձեռք բերել։

1980-ականների սկզբներին, արհեստական ինտելեկտի հետազոտությունները վերակենդանացան, պայմանավորված էքսպերտ համակարգերի կոմերցիոն հաջողությամբ[34], արհեստական ինտելեկտի ձևաչափ, որ նմանակում է մասնագետների գիտելիքն ու վերլուծական ունակությունները։ 1985 թվականին արհեստական ինտելեկտի շուկան հատել էր միլիարդ դոլարի սահմանը։ Միևնույն ժամանակ Ճապոնիայի հինգերորդ սերնդի մեքենաների ծրագիրը ոգեշնչեց ԱՄՆ և Բրիտանական կառավարություններին վերականգնել արհեստական ինտելեկտի ակադեմիական հետազոտությունների ֆինանսավորումը[7]։ Այնուամենայնիվ սկսելով 1987 թվականի Լիսպ մեքենաների փլուզմամբ, ևս մեկ անգամ հեղինակազրկվելով, արհեստական ինտելեկտը ընկավ երկրորդ, ավելի երկարատև ընդմիջման փուլ[9]։

1990-ականների վերջերին և 21-րդ դարի սկզբում, արհեստական ինտելեկտը սկսեց օգտագործվել լոգիստիկայում, տվյալների մշակման, բժշկական ախտորոշման և այլ բնագավառներում[21]։ Հաջողությունը կապված էր համակարգչային հզորության բարձրացմամբ (տես Մուռի օրենք), կոնկրետ խնդիրների լուծմանը առավել մեծ ուշադրությամբ, արհեստական ինտելեկտի և այլ բնագավառների greater emphasis on solving specific problems, new ties between AI and other fields (ինչպիսիք վիճակագրություն, տնտեսագիտություն և մաթեմատիկական օպտիմիզացիա) միջև նոր կապերի հաստատմամբ, և հետազոտողներին պահպանել մաթեմատիկական մեթոդներն ու գիտական ստանդարտները[35]։ Deep Blue-ն 1997 թվականի մայիսի 11-ին դարձավ առաջին շախմատ խաղացող համակարգչային համակարգը, որ հաղթեց աշխարհի չեմպիոն Գարրի Կասպարովին։[36]

2011 թվականին, Jeopardy! հեռուստախաղի ցուցադրական հանդիպման ժամանակ, IBM-ի հարցուպատասխան Վաթսոն համակարգը նշանակալի տարբերությամբ հաղթել է երկու մեծագույն Jeopardy! մեծագույն չեմպիոնների՝ Բրեդ Ռուտերին և Կեն Ջենինգսին։[37] Արագ համակարգիչները, ալգորիթմական բարելավումները և հասանելիությունը մեծ տվյալներին մեքենայական ուսուցման և ընկալման հնարավորություն ստեղծեցին, տվյալների վրա հիմնված խոր ուսուցման մեթոդները սկսեցին գերակշռել ճշգրտության թեստերում[38]։ Kinect-ը, որը ապահովում է 3D մարմին–շարժում ինտերֆեյս է ապահովում Xbox 360-ի և Xbox One-ի համար օգտագործում է ալգորիթմներ արհեստական ինտելեկտի երկարատև հետազոտությունների շնորհիվ[39] այնպես ինչպես խելացի անձնական օգնականը սմարթֆոնում[40]։ 2016 թվականի մարտին, AlphaGo-ն Go մրցույթում, Go-ի չեմպիոն Լի Սեդոլին հինգ խաղից չորսում հաղթեց, դառնալով առաջին համակարգչային Go-խաղացող համակարգը, որը հաղթեց պրոֆեսիոնալ Go խաղացողին առանց արգելքների[5][41]։ 2017 թվականին Go-ի ապագան համաժողովում, AlphaGo-ն Կե Ցե-ի հետ երեք խաղից բաղկացած մրցույթում հաղթեց նրան[42], ով շուրջ երկու տարի աշխարհի թիվ 1 խաղացողն էր[43][44]։ Սա նշանակալի իրադարձություն էր արհեստական ինտելեկտի զարգացման բնագավառում, քանի որ Go-ն չափազանց բարդ խաղ է, ավելի քան շախմատը։

Համաձայն Բլումբերգի, 2015 թվականը արհեստական ինտելեկտի համար նշանակալի տարի էր, ընդ որում արհեստական ինտելեկտը գուգլում օգտագործող ծրագրային ապահովման նախագծերի քանակը աճել է 2012 թվականի "հատուկենտ օգտագործումից" մինչև 2,700 նախագծեր։ Փաստացի տվյալները ցույց են տալիս, որ 2011 թվականից սկսած պատկերների մշակման առաջադրանքներում սխալների քանակը էապես նվազել է[45]։ Դա բացատրվում է հաշվարկվող ենթակառուցվածքների, հետազոտման գործիքների և տվյալների բազմությունների աճի շնորհիվ հասանելի արհեստական նեյրոնային ցանցի ընդլայնմամբ[10] Այլ օրինակներ են՝ Skype համակարգը, որ մի լեզվից մյուս լեզվին ավտոմատ թարգմանություն է ապահովում և Facebook-ը, որը կարող է պատկերները նկարագրել կույր մարդկանց[45]։ 2017 թվականի հարցումներում կազմակերպություններից հինգից մեկը հայտարարում է, որ "Արհեստական ինտելեկտը զետեղել են որոշ առաջարկություններում կամ գործընթացներում"[46][47]։

Հիմունքներ

[խմբագրել | խմբագրել կոդը]Տիպիկ արհեստական ինտելեկտը ընկալում է միջավայրը և իրականացնում է գործողություններ, որոնք առավելագույնի են հասցնում հաջողությամբ իր նպատակներին հասնելու հնարավորությունը[48]։ Արհեստական ինտելեկտի ենթադրվող նպատակետը կարող է լինել պարզ ("1, երբ Go խաղալիս հաղթում է, հակառակ դեպքում՝ 0") կամ բարդ ("Կատարել նախկինում պարգևներ բերած գործողություններին մաթեմատիկորեն նմանատիպ գործողություններ"). Նպատակները կարող են հստակ սահմանվել, կամ կարող են դրվել։ Եթե արհեստական ինտելեկտը ծրագրված է "ուսուցման ամրապնդման" համար, նպատակները կարող են անուղղակի ստիպել որոշակի վարքագծեր խրախուսել և այլերը պատժել։ [Ն 1] Այլ կերպ էվոլյուցիոն համակարգը կարող է նպաստել նպատակներին օգտագործելով "հարմարվողականության ֆունկցիան" վերափոխվելու գերադասաբար փոխարինել բարձրակարգ արհեստական ինտելեկտի համակարգերը, սա նման է թե ինչպես կենդանիները զարգացան իրենց որոշակի նպատակների, ինչպես սնունդ գտնելն է, կամ ինչպես կարելի է շներին բազմացնել արհեստական ընտրության միջոցով, որպեսզի ցանկալի հատկություններ ժառանգեն։[49] Որոշ արհեստական ինտելեկտ համակարգեր, ինչպիսին մոտակա-հարևանը, տրված նպատակի փոխարեն դիտարկում են նմանությամբ, բացառությամբ, որ նպատակները ինչ որ կերպ թաքնված են դրանց ուսուցման տվյալներում։[50] Այսպիսի համակարգերը կարող են համարվել ոչ նշատակային համակարգեր, որոնց "նպատակն" է հաջողությամբ իրականացնել իրենց նեղ դասակարգման խնդիրը։.[51]

Արհեստական ինտելեկտը հաճախ պտտվում է ալգորիթմների օգտագործման շուրջ։ Ալգորիթմը հստակ հրահանգների բազմություն է, որ կարող է իրականացնել մեխանիկական համակարգիչը։[Ն 2] Բարդ ալգորիթմը հաճախ կառուցվում է ավելի պարզ ալգորիթմների միջոցով։ Պարզ ալգորիթմի օրինակ է կետ-խաչ օպտիմալ խաղալու հետևյալ եղանակը․[52]

- եթե ունեք "վտանգ" (այսինքն, անընդմեջ երկուսը), վերցրեք մնացած դաշտը։ Հակառակ դեպքում,

- եթե "պատառաքաղ" քայլը միաժամանակ երկու վտանգ կարող է ստեղծել, կատարեք այդ քայլը։ Հակառակ դեպքում,

- վերցրեք դաշտի կենտրոնը, եթե այն ազատ է։ Հակառակ դեպքում,

- եթե ձեր հակառակորդը խաղացել է անկյունում, վերցրեք հանդիպակաց անկյունը։ Հակառակ դեպքում,

- վերցրեք դատարկ անկյունը։ Հակառակ դեպքում,

- վերցրեք դատարկ դաշտը։

Արհեստական ինտելեկտի շատ ալգորիթմներ ունակ են սովորել տվյալների հիման վրա, դրանք կարող են ինքնակատարելագործվել` հիմնվելով փորձերի արդյունքների վրա (ռազմավարություններ, կամ "թերթել կանոնները", որոնք նախկինում լավ են աշխատել), կամ կարող են իրենք այլ ալգորիթմ գրել։ "Աշակերտներից" ոմանք, ներառյալ Բեյեսյան ցանցեր, լուծումների ծառեր և մոտակա հարևան, տեսականորեն կարող են անսահման տվյալների, ժամանակի և հիշողության առկայության դեպքում, սովորել մոտարկել կամայական ֆունկցիա, ներառյալ ողջ աշխարհը լավագույնը նկարագրող մաթեմատիկական ֆունկցիաների համադրությունը։ Ըստ էության այս աշակերտները կարող են դուրս բերել ողջ հնարավոր գիտելիքը, դիտարկելով յուրաքանչյուր հնարավոր վարկածներ և համադրելով դրանք տվյալների հետ։ Պրակտիկայում, անհնար է դիտարկել ամեն մի հնարավորություն, "կոմբինատոր պոռթկման" երևույթի պատճառով, որտեղ պրոբլեմի լուծման համար անհրաժեշտ ժամանակը աճում է էքսպոնենցիալ։ Արհեստական ինտելեկըի հետազոտությունների մեծ մասը ներառում է այն, թե ինչպես լայն հնարավորություններից առանձնացնել և բացառել տարբերակները, որոնց միջոցով հաջողության հասնելը քիչ հավանական է[53]։ >[54] Օրինակ, երբ քարտեզի վրա Դենվերից Նյու Յորք ամենակարճ երթուղին որոնելիս կարելի է ամենակարճ ճանապարհ Սան Ֆրանցիսկոյով կամ հեռու արևմուտքով անցնող ցանկացած այլ ճանապարհ բացառել, այդպիսով, ամենակարճ երթուղին փնտրող արհեստական ինտելեկտի ալգորիթմը կարող է խուսափել ամեն հնարավոր ճանապարհ դիտարկող կոմբինատոր պոռթկումից[55]։ Արհեստական ինտելեկտի ամենավաղ (և ամենահասկանալի) մոտեցումը սիմվոլիզմն էր (այնպիսին ինչպիսին ձևական տրամաբանությունն է)։ "Եթե առողջ չափահաս մարդը ջերմում է, ապա հնարավոր է նա գրիպով հիվանդ է"։ Հաջորդ, ավելի ընդհանուր մոտեցումը Բայեսյան եզրակացությունն է, "Եթե ընթացիկ այցելուն ջերմում է, դիտարկեք հավանականությունը, որ նա հիվանդ է գրիպով այս-այս կերպ"։ Երրորդ ավելի ընդգրկուն մոտեցումը, չափազանց տարածված արհեստական ինտելեկտի սովորական կիրառումներում, անալոգայնությունը։ "Հետազոտելով նախորդ այցելուների մասին տեղեկությունները՝ ջերմությունը, ախտանիշները, տարիքը և այլ գործոններ, որոնք հիմնականում համընկնում են այս հիվանդի ցուցանիշների հետ, այդ հիվանդների քանի %-ն էր գրիպով հիվանդ"։ Չորրորդ մոտեցումն ավելի դժվար է հասկանալ, բայց հիմնված է ուղեղի ինտուիտիվ աշխատանքի վրա․ արհեստական նեյրոնային ցանցի մոտեցումը օգտագործում է արհեստական "նեյրոնները", որոնք կարող են սովորել իրենց համեմատելով ցանկալի արդյունքների հետ և փոխելով ներքին նեյրոնների միջև ուժեղ կապերը, "հզորացնել" կապերը, որոնք թվում են օգտակար։ Այս չորս հիմնական մոտեցումները կարող են մասնակի համընկնել միմյանց և էվոլյուցիոն համակարգերի հետ, օրինակ նեյրոնային ցանցերը կարող են սովորել եզրակացնել, ընդհանրացնել և նմանակել։ Որոշ համակարգեր անուղղակի կամ ուղղակի օգտագործում են այս մոտեցումների բազմազանությունը, այլ արհեստական ինտելեկտի և ոչ ալգորիթմների հետ մեկտեղ[56], լավագույն մոտեցումը հաճախ կախված է խնդրից։[57][58]

Ուսուցող ալգորիթմները աշխատում են այն հիմունքներով, որ ռազմավարությունները, ալգորիթմները և եզրակացությունները, որոնք լավ աշխատել են անցյալում, հավանաբար կշարունակեն լավ աշխատել նաև ապագայում։ Այս եզրակացությունները կարող են լինել ակնհայտ, օրինակ "քանի որ վերջին 10,000 օրերի ընթացքում արևը ծագում է ամեն առավոտ, հավանաբար այն կծագի նաև վաղն առավոտյան"։ Կարող են լինել երանգավորված, օրինակ ընտանիքների "X%-ը աշխարհագրական առումով տարբեր տեսակներ ունենալ գունային տարբերակներով, ուստի Y%-ի հնարավորությամբ գոյություն ունի սև կարապ"։ Ուսանողները նաև աշխատում են "Օկկամի ածելիի" հիմքի վրա։ Պարզագույն տեսությունը, որ բացատրում է տվյալները, ամենահավանականն է։ Հետևաբար, ուսանողը հաջողելու համար պարզագույն տեսությունները, պետք է նախընտրի բարդերից, բացառությամբ երբ բարդ տեսությունը էապես լավն է։ Անցած ուսումնական փորձի հիման վրա չափազանց բարդ տեսության միջոցով տվյալների վերանայումը, կարգավորումը հայտնի է որպես վերապատրաստում։ Շատ համակարգեր փորձում են նվազեցնել վերապատրաստումը գնահատելով, թե որքանով է ենթադրությունը համապատասխանում տվյալներին, բացառում բարդ ենթադրությունները։[59] Բացի դասական վերապատրաստումից ուսանողները կարող են հիասթափվել "սխալ դաս սովորելուց"։ Խաղալիքի օրինակը հետևյալն է, պատկերի դասակարգիչը, որ պատրաստված է ճանաչել միայն շագանակագույն ձիեր և սև կատուներ, կարող է եզրակացնել, որ բլոր շագանակագույն նմուշները հավանաբար ձիեր են։[60] Ի տարբերություն մարդկանց պատկերների, ժամանակակից դասակարգիչները պատկերի բաղադրիչների միջև տարածական կապը չեն կարողանում որոշել, փոխարենը դրանք ուսումնասիրում են պիքսելների աբստրակտ շաբլոնները, որոնք մարդիկ անտեսում են, բայց որոնք գծայնորեն կապվում են իրական օբյեկտների որոշ տեսակների պատկերների հետ։ Այդպիսի շաբլոնի թեթև տեղ-տեղ համընկնումը իրական պատկերի հետ բերում է "մրցակից" պատկերի, ինչը համակարգը սխալ է դասակարգում։[Ն 3][61][62][63]

Մարդկանց համեմատությամբ գոյություն ունեցող արհեստական ինտելեկտի համակարգերի մոտ բացակայում են մարդու մի քանի "առողջ մտածելակերպի" հատկանիշներ; մարդիկ ունեն նաիվ ֆիզիկայի, ինչպիսիք են տարածություն, ժամանակ և ֆիզիկական փոխազդեցություններ, մասին մտածելու հզոր մեխանիզմներ։ Սա նույնիսկ փոքր երեխաներին հնարավորություն է տալիս հեշտությամբ եզրակացնել "Եթե այս գրիչը գլորի սեղանից, ապա այն կընկնի հատակին"։ Մարդիկ նաև "ժողովրդական հոգեբանության", որն օգնում է մեկնաբանել բնական լեզվով նախադասությունները, օրինակ, "Քաղաքային խորհուրդը ցուցարարներիդիմումը մերժեց, քանի որ նրանք բռնություն էին քարոզում"։ (Արհեստական ինտելեկտին դժվար է որոշել ավագանու անդամներն են, թե ցուցարարներն են բռնություն քարոզում։)[66][67][68] "Ընդհանուր գիտելիքի" պակասը նշանակում է, որ արհեստական ինտելեկտն այլ սխալներ է թույլ տալիս քան մարդը։ Օրինակ, գոյություն ունեցող ինքնակառավարվող ավտոմեքենաները չեն կարող եզրակացնել հետիոտնի ոչ գտնվելու վայրի, ոչ նրա տեղաշարժվելու ուղղության մտադրության մասին, փոխարենը պետք է օգտագործեն ոչ մարդկային մեթոդներ, պատահարներից խուսափելու համար[69][70][71]։

Խնդիրներ

[խմբագրել | խմբագրել կոդը]Արհեստական ինտելեկտի հետազոտության նպատակն է ստեղծել տեխնոլոգիա, որը թույլ է տալիս համակարգիչներին և մեքենաներին խելացի գործել։ Ինտելեկտ ստեղծելու հիմնական խնդիրը բաժանվում է ենթախնդիրների։ Դրանք բաղկացած են որոշակի առանձնահատկություններից կամ հնարավորություններից, որոնք հետազոտողներն ակնկալում են խելամիտ համակարգից։ Ստորև նկարագրված հատկությունները առավել ուշադրության են արժանացել[12]։

Մտահանգում, խնդրի լուծում

[խմբագրել | խմբագրել կոդը]Վաղ հետազոտողները մշակել էին ալգորիթմներ, որոնք քայլ առ քայլ նմանակում էին մտահանգումները, որոնք մարդիկ օգտագործում էին հանելուկներ լուծելիս և տրամաբանական եզրակացություններ անելիս[72]։ 1980-ականների և 1990-ականների վերջերին արհեստական ինտելեկտի հետազոտողները, օգտագործելով հավանականության և տնտեսագիտության հասկացությունները, մշակեցին անորոշ կամ ոչ ամբողջական տեղեկատվության հետ գործելու մեթոդներ[73]։

Այս ալգորիթմները բավարար չեն ծավալուն քննարկումներ պահանջող խնդիրների համար, որովհետև դրանք կտանեն "կոմբինատոր պայթյունի"․ խնդիրների բարդացմանը զուգահեռ դրանց լուծումները ակնհայտորեն դանդաղում են[53]։ Փաստացի, նույնիսկ մարդիկ հազվադեպ են օգտագործում քայլ-առ-քայլ եզրակացությունը, որը վաղ արհեստական ինտելեկտի համակարգերը կարող էին մոդելավորել։ Նրանք իրենց խնդիրների մեծ մասը լուծում են` օգտագործելով արագ ինտուիտիվ դատողությունները[74]։

Գիտելիքի ներկայացում

[խմբագրել | խմբագրել կոդը]

Գիտելիքի ներկայացումը[75] և գիտելիքի մշակումը[76] արհեստական ինտելեկտի դասական հետազոտության մեջ կենտրոնական տեղ են գրավում։ Որոշ "էքսպերտ համակարգեր" փորձում են որոշ նեղ տիրույթի վերաբերող մասնագետների հստակ գիտելիքները մեկտեղել։ Բացի այդ որոշ նախագծեր փորձում են միջին մարդուն հայտնի "ողջամիտ գիտելիքները" հավաքել աշխարհին վերաբերող ընդհանուր գիտելիքների տվյալների բազայում։ Ողջամիտ գիտելիքների բազայում տեղ կգտնեն օբյեկտները, հատկությունները, կատեգորիաները և օբյեկտների միջև հարաբերությունները[77], իրադրությունները, միջոցառումները, իրավիճակները և ժամանակը[78], պատճառները և հետևանքները[79], գիտելիք գիտելիքի մասին (ինչ մենք գիտենք այն մասին, թե ինչ այլ մարդիկ գիտեն)[80] և շատ այլ քիչ հետազոտված բնագավառներ։ Ներկայացումը, թե "Ինչ գոյություն ունի" համակարգչային օնտոլոգիա է՝ օբյեկտների, հարաբերությունների, գաղափարների և հատկությունների ֆորմալ նկարագրություն, որ ծրագրային ագենտները դրանք կարող են մեկնաբանել։ Այս բոլորի սեմանտիկան ամրագրվում է որպես հասկացությունների, դերերի և անհատների նկարագրողական տրամաբանություն, և սովորաբար Վեբ Անթոլոգիական լեզվով իրականացվում են որպես դասեր, հատկություններ և անհատներ[81]։ Ամենաընդհանուր անթոլոգիաները վերին անթոլոգիաներն են, որոնք փորձում են ողջ գիտելիքի հիմք ապահովել[82]` դառնալով միջնորդ տիրույթային անթոլոգիաների միջև, որոնք ներառում են որոշակի գիտելիքների տիրույթների մասին կոնկրետ գիտելիքներ։ Գիտելիքի այսպիսի ֆորմալ ներկայացումը կարող է օգտագործվել բովանդակության վրա հիմնված ինդեքսավորման և որոնման մեջ[83], պատահարի նկարագրության[84], կլինիկական որոշումների աջակցման[85], գիտելիքի հայտնաբերման մեջ ("հետաքրքիր" և գործուն եզրակացություններ տվյալների մեծ բազաներից փնտրելիս)[86], և այլ բնագավառներում[87]։

Գիտելիքի ներկայացման ամենադժվար խնդիրներից են․

Շատ բաներ, ինչ մարդիկ գիտեն, "աշխատանքային ենթադրությունների" տեսք են ստանում։ Օրինակ, երբ խոսակցության մեջ թռչուն է հիշատակվում, մարդիկ, սովորաբար պատկերացնում են բռունցքի չափ ունեցող կենդանի, որ երգում է և թռչում։ Սրանցից ոչինչ ճիշտ չէ բոլոր թռչունների համար։ Ջոն Մակկարտին այս խնդիրը ներկայացրեց 1969 թվականին[88] որպես դասակարգման խնդիր․ կամայական ողջամիտ կանոնի համար, որ արհեստական ինտելեկտի հետազոտողները պետք է ներկայացնեն, գոյություն ունեն բազում բացառություններ։ Գրեթե ոչինչ բացարձակ ճիշտ կամ սխալ չկա, ինչ աբստրակտ տրամաբանությունն է պահանջում։ Արհեստական ինտելեկտի հետազոտողները այս խնդրի բազմաթիվ լուծումներ են ուսումնասիրել[89]։

- Ողջամիտ գիտելիքի լայնությունը։ Փաստերը, որ միջին մարդը գիտի, մեծաքանակ են։ Հետազոտական նախագծերը, որոնք փորձում են ողջամիտ գիտելիքի ամբողջական տվյալների բազա ստեղծել, պահանջում են հսկայական ծավալի անթոլոգիական պրոյեկտման աշխատանքներ, որոնք պետք է արվեն ձեռքով՝ մեկ բարդ հասկացություն մեկ մոտեցմամբ[90]։

- Ողջամիտ գիտելիքի սիմվոլիկ տեսքը։ Շատ բաներ, որ մարդիկ գիտեն, չեն ներկայացված "փաստերի" կամ "պնդումների" ձևով, որ նրանք կարողանային բանավոր ներկայացնել։ Օրինակ, շախմատիստը կարող է խուսափել կոնկրետ շախմատային դիրքից, որովհետև այն "շատ բացահայտ է"[91] կամ արվեստի քննադատը առաջին հայացքից կարող է հասկանալ, որ քանդակը կեղծ է։[92] Սրանք անգիտակցական և ենթասիմվոլիկ ինտուիցիաներ կամ միտումներ են մարդու ուղեղում[93]։ Այսպիսի գիտելիքը տեղեկացնում է, աջակցում և ապահովում է սիմվոլիկ գիտակցված գիտելիքի միջավայր։ Ինչպես կապակցված ենթասիմվոլային հիմնավորման խնդրի դեպքում, հույս կա, որ իրադրության արհեստական ինտելեկտը, հաշվարկային արհեստական ինտելեկտը կամ վիճակագրական արհեստական ինտելեկտը կարող են ապահովել ներկայացնելու այս կարգի գիտելիք[93]։

Պլանավորում

[խմբագրել | խմբագրել կոդը]Խելացի ագենտները պետք է կարողանան նպատակներ դնել և դրանց հասնել[94]։ Դրանք պետք է աշխարհի դրության ապագայի ներկայացման եղանակներ ունենան և ի վիճակի լինեն կանխագուշակումներ անել, թե ինչպես իրենց գործողությունները կփոխեն դա և եղած տարբերակներից ընտրել առավելագույն օգտակարը[95]։

Դասական պլանավորման համակարգերում, ագենտը կարող է ենթադրել, որ աշխարհում միակ գործող համակարգն է, ագենտին հնարավորություն տալով վստահ լինել իր գործողությունների հետևանքների մեջ[96]։ Այնուամենայնիվ, եթե ագենտը միակ դերակատարը չէ, ապա պահանջվում է, որ ագենտը կարողանա գործել անորոշության պայմաններում։ Այսինքն ագենտը պետք է կարողանա ոչ միայն գնահատել միջավայրը և կանխատեսումներ անել, այլ նաև գնահատել իր կանխատեսումները և դրանց հիման վրա ադապտացվել[97]։

Բազմա-ագենտ պլանավորումը տրված նպատակին հասնելու համար օգտագործում է բազմաթիվ ագենտների համագործակցությունն ու մրցակցությունը։ Այսպիսի վարքագիծն օգտագործվում է էվոլյուցիոն ալգորիթմների և ամբոխային մտածողության կողմից[98]։

Ուսուցում

[խմբագրել | խմբագրել կոդը]Մեքենայական ուսուցումը արհեստական ինտելեկտի ստեղծումից ի վեր դրա հիմնարար հետազոտությունների հայեցակարգն է[99], այն համակարգչային ալգորիթմների ուսումնասիրությունն է, որը փորձերի շնորհիվ ավտոմատ բարելավվում է[100][101]։

Չվերահսկվող ուսուցումը դա մուտքային հոսքում շաբլոններ գտնելու ունակությունն է։ Վերահսկվող ուսուցումը ներառում է թե դասակարգումը, թե թվային ռեգրեսիան։ Դասակարգումն օգտագործվում է որոշելու, թե առարկան ինչ կատեգորիայի է պատկանում մի քանի կատեգորիայի մի շարք օրինակներ դիտարկելուց հետո։ Ռեգրեսիան փորձ է ստեղծել ֆունկցիա, որն արտահայտում է մուտքի և ելքի միջև հարաբերությունը և կանխատեսում, թե ինչպես ելքային տվյալները կփոխվեն մուտքային տվյալների փոփոխմանը զուգահեռ[101] Դասակարգողները և ռեգրեսիոն սովորողները, երկուսն էլ կարող են դիտարկվել որպես "ֆունկցիայի մոտարկողներ", որ փորձում են սովորել անհայտ (հնարավոր է անուղղակի) ֆունկցիա, օրինակ, սպամ դասակարգիչը կարող է դիտարկվել որպես ֆունկցիայի ուսումնասիրություն, որը էլեկտրոնային նամակի տեքստը արտապատկերում է երկու կատեգորիաներից մեկին, "սպամ" կամ "ոչ սպամ"։ Հաշվողական ուսուցման տեսությունը կարող է գնահատել սովորողներին հաշվողական բարդությամբ, նմուշի բարդությամբ (որքան տվյալ է պահանջվում), կամ օպտիմիզացիոն տեսության այլ հասկացություններով[102]։ Ուժեղացված ուսուցման դեպքում[103] գործակալը լավ պատասխանների դեպքում պարգևատրում է, իսկ վատերի դեպքում պատժում։ Իր խնդրահարույց տարածքում գործող ռազմավարություն ձևավորելու համար գործակալն օգտագործում է պարգևների և պատժամիջոցների հաջորդականություն։

Բնական լեզվի վերամշակումը

[խմբագրել | խմբագրել կոդը]

Բնական լեզվի վերամշակումը[104] մեքենային տալիս է մարդկային լեզուն կարդալու և հասկանալու ունակություն։ Բնական լեզվի բավականաչափ հզոր համակարգը թույլ կտա օգտագործել բնական լեզու-օգտվող ինտերֆեյսը և ուղղակիորեն գիտելիք քաղել անմիջականորեն մարդկանց կողմից ստեղծված աղբյուրներից։ Բնական լեզվի մշակման որոշ պարզ տարբերակներ ներառում են տեքստի որոնում, տեղեկատվության վերլուծություն, հարցերի պատասխանում[105] և մեքենայական թարգմանություն[106] Ժամանակակից շատ մոտեցումներ տեքստի սինտաքսիս ներկայացումը կառուցելու համար օգտագործում են բառի համընկնման հաճախականությունը։ "Բանալի խոսքերի որոնման" ռազմավարությունը ընդունված է և լայնածավալ, սակայն երբեմն անիմաստ, օրինակ "շուն" բառը փնտրելիս, կարող է բաց թողնվել "պուդել" բառը պարունակող փաստաթղթերը։ "Լեքսիկալ նմանության" ռազմավարություններն օգտագործում են այնպիսի բառեր, ինչպիսին "վթարն" է գնահատելու նյութի զգացմունքայնությունը։ Ժամանակակից վիճակագրական մոտեցումները կարող են միավորել ինչպես այս բոլոր ռազմավարությունները, այնպես էլ այլք և հաճախ հասնում են ընդունելի ճշգրության էջի կամ պարբերության մակարդակով, սակայն առանձին նախադասությունների դասակարգման տեսակետից մնում են սեմանտիկորեն անհասկանալի։ Բացի ողջամիտ գիտելիքի վերծանման սովորական բարդությունները, բնական լեզվի մշակման գոյություն ունեցող համակարգերը շատ թույլ են գործարար ծրագրերում կենսունակ դարձնելու համար։ Բացի բնական լեզվի սեմանտիկ մշակման վերջնական նպատակն է ողջամիտ գիտելիքի լիակատար ըմբռնումը[107]։

Ընկալում

[խմբագրել | խմբագրել կոդը]

Մեքենայական ընկալումը[108] հնարավորություն է սենսորներից եկող ազդանշաններն օգտագործել (ինչպիսիք են տեսախցիկները (տեսանելի սպեկտր կամ ինֆրակարմիր), միկրոֆոնները, անլար ազդանշանները և ակտիվ լիդարները, ռադարը և շոշափող սենսորները) աշխարհի ասպեկտները հասկանալու համար։ Կիրառումները ներառում են խոսքի ճանաչումը[109], դեմքի ճանաչումը և օբյեկտի ճանաչումը[110]։ Համակարգչային տեսողությունը տեսողական մուտքը վերլուծելու ունակությունն է։ Այսպիսի ներդրումը սովորաբար երկիմաստ է․ հսկա, հիսուն մետր հասակ ունեցող հետիոտնը հեռվից կարող է նույն պիքսելներն արձակել, որքան սովորական չափսերի մերձակայքում գտնվող հետիոտնը։ Արհեստական ինտելեկտի համակարգից պահանջել կարծիք հայտնել տարբեր մեկնաբանությունների հարաբերական ճշմարտանմանության և հիմնավորվածության վերաբերյալ, ելնելով օրինակ "սկզբնական մոդելից" գնահատել, որ հիսուն մետրանոց հետիոտն գոյություն չունի[111]։ համակարգչային տեսողության խնդիրները ներառում են պատկերի ստացումը, մշակումը, վերլուծությունը և թվային պատկերների յուրացումը և իրական աշխարհից բազմաչափ տվյալների ձեռքբերումը, լուծումների տեսքով թվային կամ սիմվոլիկ ինֆորմացիա ստանալու համար։

Շարժում և մանիպուլացիա

[խմբագրել | խմբագրել կոդը]Արհեստական ինտելեկտը մեծապես օգտագործվում է ռոբոտների մեջ[112] Բարձրակարգ ռոբոտային բազուկները և այլ արդյունաբերական ռոբոտները լայնորեն օգտագործվում են ժամանակակից գործարաններում, փորձից կարող են սովորել ինչպես արդյունավետ շարժվել, չնայած շփման և տեղափոխման սահունության առկայությանը[113]։ Ժամանակակից շարժվող ռոբոտը, երբ տրված է փոքր, հաստատուն և տեսանելի միջավայր, կարող է որոշել իր գտնվելու վայրը և քարտեզագրել այն, այնուամենայնիվ դինամիկ միջավայրերը, ինչպես (էնդոսկոպիայում) հիվանդի շնչառական օրգանի ներսում, ավելի մեծ մարտահրավեր է առաջացնում։ Շարժման պլանավորումը դա շարժման առաջադրանքը "պրիմիտիվների" շարժումների տրոհելու պրոցես է, ինչպիսիք են անհատական համատեղ շարժումները։ Այսպիսի շարժումը հաճախ ներառում է համատեղ գործողություն, երբ շարժումը պահանջում է օբյեկտի հետ ֆիզիկական շփման մեջ մնալ:[114][115][116]։ Մորավեկի պարադոքսը ընդգծում է, որ ցածր մակարդակի սենսորային շարժման հմտությունները, որոնք մարդիկ ընդունում են որպես ինքնին հասկանալի, դժվար է ծրագրավորել ռոբոտում։ Պարադոքսը Հանս Մորավեկի անունն է կրում, ով 1988 թվականին հայտարարեց, որ "համեմատաբար հեշտ է համակարգչին հրահանգել ցուցադրել լավ արդյունքներ չափահասին հատուկ ինտելեկտուալ կամ շաշկու խաղում, և դժվար կամ անհնար է դրանց տալ մեկ տարեկանի հմտություններ, որ գալիս են ընկալումից և շարժունակությունից"[117][118]։ Սա բացատրվում է նրանով, որ ի տարբերություն շաշկու, ֆիզիկական ճարտարությունը բնական ընտրության ուղիղ թիրախն է եղել միլիոնավոր տարիներ[119]։

Սոցիալական ինտելեկտ

[խմբագրել | խմբագրել կոդը]

Մորավեկի պարադոքսը կարող է ընդլայնվել սոցիալական ինտելեկտի բազմաթիվ ձևերի վրա[121][122]։ Բազմաթիվ գործակալների միջև բաշխված ինքնավար տրանսպորտային միջոցների կոորդինացումը մնում է բարդ պրոբլեմ[123]։ Հուզական հաշվարկները միջճյուղային հովանոց է, որ ներառում է համակարգեր, որոնք ճանաչում, մեկնաբանում, մշակում է մարդկային զգացմունքները։[124][125][126] Հուզական հաշվարկների չափավոր հաջողությունները, ներառյալ տեքստային տրամադրության վերլուծությունները և վերջերս մուլտիմոդալ հուզական վերլուծությունները, որտեղ արհեստական ինտելեկտը դասակարգում է տեսագրված թեմայով դրսևորվող ազդեցությունները[127]։

Երկարաժամկետ հեռանկարում սոցիալական հմտությունները և մարդկային զգացմունքները հասկանալը և խաղերի տեսությունը արժեքավոր կլինի սոցիալական ագենտի համար։ Մարդկանց գործողությունների շարժառիթները և հուզական վիճակները հասկանալու միջոցով նրանց գործողությունները կանխատեսելու կարողությունն ագենտին հնարավորություն կտա ավելի լավ որոշումներ ընդունել։ Որոշ համակարգեր նմանակում են մարդկային զգացմունքները և արտահայտությունները մարդկային փոխհարաբերության զգացմունքային դինամիկայում ավելի զգայուն երևալու համար, այլ կերպ նպաստելու մարդ համակարգիչ փոխազդեցությանը[128] Նման կերպ որոշ վիրտուալ օգնականներ ծրագրավորված են զրույց վարել և նույնիսկ կատակել, սա նաիվ օգտվողների մոտ ոչ իրատեսական տպավորություն է ստեղծում, թե որքան ինտելեկտուալ են գոյություն ունեցող համակարգչային ագենտները[129]։

Ընդհանուր ինտելեկտ

[խմբագրել | խմբագրել կոդը]Պատմականորեն այնպիսի նախագծերը, ինչպիսիք են Cyc գիտելիքների բազան (1984–) և զանգվածային ճապոնական հինգերորդ սերնդի համակարգիչ նախաձեռնությունը (1982–1992) փորձեց ընդգրկել մարդկային գիտելիքի ողջ բազմազանությունը։ Այս վաղ նախագծերը չկարողացան խուսափել ոչ-քանակական սիմվոլիկ տրամաբանության մոդելների սահմանափակումներից և հետադարձ հայացքից մեծապես թերագնահատվեց արհեստական ինտելեկտի միջտիրույթային դժվարությունը։ Ներկայումս ժամանակակից արհեստական ինտելեկտի հետազոտողները փոխարենը մեծ մասամբ աշխատում են հեշտ մշակվող "նեղ արհեստական ինտելեկտի" կիրառությունների վրա (ինչպիսիք բժշկական ախտորոշումը և ավտոմոբիլային նավիգացիան են)[130]։ Շատ հետազոտողներ կանխատեսում են, որ տարբեր տիրույթներում "նեղ արհեստական ինտելեկտի" աշխատանքները ի վերջո կներառվեն արհեստական ընդհանուր ինտելեկտով մեքենայի մեջ (AGI), միավորելով այս հոդված բերված նեղ հմտությունները և ինչ որ տեսակետից նույնիսկ կգերազանցեն մարդկային կարողությունները այս բնագավառներից մեծ մասում[16][131]։ Շատ հաջողություններ ունեն ընդհանուր միջտիրույթային նշանակություն։ Մեկ բարձր մակարդակի օրինակ է, որ DeepMind-ը 2010 թվականին մշակեց "ընդհանրացված արհեստական ինտելեկտ", որն ինքնուրույն կարող է սովորել շատ բազմազան Atari խաղեր և հետագայում մշակեց համակարգի տարբերակ, որը հաջողում է հաջորդական ուսուցման պրոբլեմը[132][133][134]։ Բացի ուսուցման փոխանցումից[135] վարկածային ընդհանուր արհեստական ինտելեկտի առաջխաղացումը կարող է ներառել ռեֆլեկտիվ կառուցվածքի զարգացումը, որը կարող է մասնակցել տեսական որոշումների ընդունման մեջ և պարզել, թե ինչպես "անջատել" համապարփակ գիտելիքների բազան կառուցվածք չունեցող համաշխարհային սարդոստայնից։[4] Ոմանք պնդում են, որ ինչ որ (դեռևս չբացահայտված) կոնցեպտուալ պարզ, բայց մաթեմատիկորեն բարդ "Վարպետ Ալգորիթմ" կարող է տանել արհեստական ընդհանուր ինտելեկտի։[136] Ի վերջո մի քանի "երևացող" մոտեցումներ դիտարկվում են մարդկային ինտելեկտին ակնհայտ մոտ և համարում են, որ անտրոմորֆիկ հատկությունները, ինչպիսին արհեստական ուղեղն է կամ զարգացումը խթանող ռոբոտը, մի օր կարող են հասնել կրիտիկական կետի, երբ ընդհանուր ինտելեկտ կառաջանա[137][138]։

Այս հոդվածի շատ խնդիրներ նույնպես կարող են ընդհանուր ինտելեկտ պահանջել, եթե մեքենաները խնդիրները լուծեն այնպես, ինչպես մարդիկ են անում։ Օրինակ, նույնիսկ կոնկրետ պարզ խնդիրները, ինչպիսին մեքենայական թարգմանությունն է, պահանջում է, որ մեքենան գրի և կարդա երկու լեզուներով էլ, հետևի հեղինակի փաստարկներին, իմանա ինչի մասին է խոսվում և հավաստի վերարտադրի հեղինակի նախնական մտադրությունները։ Մեքենայական թարգմանության խնդիրը դիտարկվում է որպես արհեստական ինտելեկտի ամբողջական խնդիր, քանի որ բոլոր այս խնդիրները միաժամանակ պետք է լուծվեն, որպեսզի մեքենայական կատարումը մարդու թարգմանության մակարդակին հասնի։

Մոտեցումներ

[խմբագրել | խմբագրել կոդը]Արհեստական ինտելեկտի հետազոտությունները առաջնորդող միավորող տեսություն կամ պարադիգմ գոյություն չունի։ Բազմաթիվ խնդիրների վերաբերյալ հետազոտողներն անհամաձայնություններ ունեն[139]։ Երկար ժամանակ մի քանի հարց անպատասխան մնացած հարցերից են․ արհեստական ինտելեկտը արդյոք պետք է նմանակի բնական ինտելեկտին` ուսումնասիրելով հոգեբանությունը կամ նեյրոգիտությունը։ Կամ մարդու բիոլոգիայի հետ կապը նույքան անհեթեթ է, որքան թռչնի բիոլոգիայինը աերոնավիգացիոն տեխնիկայի հետ[13]։ Կարող է ինտելեկտուալ վարքագիծը նկարագրել պարզ, էլեգանտ սկզբունքներով, ինչպիսին տրամաբանությունն է կամ օպտիմիզացիոն մաթեմատիկան։ Կամ դա անհրաժեշտաբար պահանջում է լուծել մեծ թվով բոլորովին կապ չունեցող պրոբլեմներ[14]։

Կիբեռնետիկա և ուղեղի մոդելավորում

[խմբագրել | խմբագրել կոդը]1940-ականներին և 1950-ականներին մի շարք հետազոտողներ ուսումնասիրել են նեյրոկենսաբանության, ինֆորմացիոն տեսության և կիբեռնետիկայի միջև կապը։ Նրանցից ոմանք էլեկտրոնային ցանցեր օգտագործող տարրական ինտելեկտ ունեցող մեքենաներ են ստեղծել։ Այդ հետազոտողներից շատերը հավաքվել էին Անգլիայի Փրինսթոնի համալսարանում և Ռատիո ակումբում հեռահաղորդակցության հանրության ժողովին[140]։ 1960 թվականին այս մոտեցումը չի օգտագործվել, չնայած 1980-ականներին դրա տարրերը վերականգնվեցին։

Սիմվոլիկ

[խմբագրել | խմբագրել կոդը]Երբ 1950-ականների կեսերին հասանելի դարձան թվային համակարգիչները, արհեստական բանականության հետազոտողները սկսեցին պարզել, որ մարդկային բանականությունը կարելի է արտահայտել սիմվոլների մանիպուլյացիայով։ Հետազոտությունը կենտրոնացել էր երեք ինստիտուտներում․ Կարնեգի Մելոն համալսարան, Ստենֆորդի համալսարան և Մասաչուսեթսի Տեխնոլոգիական ինստիտուտ, և ինչպես նկարագրված է վերևում, յուրաքանչյուրը զարգացրել էր հետազոտության իր յուրահատուկ ձևը[141] 1960-ականներին սիմվոլիկ մոտեցումները մեծ հաջողություն ունեցան, փոքր ցուցադրական ծրագրերում բարձր մակարդակի մտածողություն նմանակելում։ Կիբեռնետիկական կամ արհեստական նեյրոնային ցանցային մոտեցումները հետին պլան մղվեցին[142]։ 1960-ականների և 1970-ականների հետազոտողները համոզվեցին, որ սիմվոլիկ մոտեցումները ի վերջո կհաջողեն ստեղծել ընդհանուր արհեստական ինտելեկտով մեքենա և դա դիտարկում էին որպես իրենց ոլորտի նպատակ։

Ճանաչողական մոդելավորում

[խմբագրել | խմբագրել կոդը]Տնտեսագետ Հերբերտ Սայմոնը և Ալեն Նյուելը ուսումնասիրել են մարդու խնդիրներ լուծելու հմտությունները և փորձել են դրանք ֆորմալիզացնել և նրանց աշխատանքը հիմք դրեց արհեստական ինտելեկտի, ինչպես նաև կոգնիտիվ գիտության, գործողությունների հետազոտման և կառավարման գիտության ոլորտում։ Նրանց հետազոտական խումբը հոգեբանական էքսպերիմենտների արդյունքներն օգտագործում էր զարգացնելու ծրագրեր, որ նմանակում են մեթոդներին, որոնք մարդիկ օգտագործում են խնդիրներ լուծելիս։ Կարնեգի Մելոն համալսարանում հիմնված այս ավանդույթը 1980 թվականի կեսերին, ի վերջո հանգեցրեց Soar կոգնիտիվ ճարտարապետության մշակմանը[143][144]։

Տրամաբանության վրա հիմնված

[խմբագրել | խմբագրել կոդը]Ի տարբերություն Սայմոնի և Նյուելի, Ջոն Մակկարտնին համարում էր, որ մեքենան չպետք է մոդելավորի մարդկանց մտքերը, այլ փոխարենը պետք է փորձի գտնել աբստրակտ հիմնավորման և խնդրի լուծման գոյությունը, անկախ մարդն այդ նույն ալգորիթմն է օգտագործում[13]։ Սթենֆորդի համալսարանի նրա լաբորատորիան մտադրված էր օգտագործել ֆորմալ տրամաբանությունը տարբեր խնդիրներ լուծելու համար, ներառյալ գիտելիքի ներկայացում, ավտոմատացված պլանավորում և մեքենայական ուսուցում[145]։ Տրամաբանությունը նաև Էդինբուրգի համալսարանի ուշադրության կենտրոնում էր, Եվրոպայի այլ երկրներում, ինչը հանգեցրեց Prolog ծրագրավորման լեզվի մշակմանը և տրամաբանական ծրագրավորում գիտության զարգացմանը[146]։

Հակատրամաբանական կամ խառնաշփոթ

[խմբագրել | խմբագրել կոդը]MIT հետազոտողները, (ինչպիսիք են Մարվին Մինսկին և Սեյմուր Փեյփերթը)[147] գտել են, որ բարդ խնդիրներ լուծելիս, ինչպիսիք համակարգչային տեսողությունն ու բնական լեզվի մշակումը, պահանջում են հրատապ լուծումներ. նրանք վիճում էին, որ չկա պարզ և ընդհանուր սկզբունք (տրամաբանության նման), որը կընդգրկի ինտիլիգենտ վարքի բոլոր ասպեկտները։ Ռոջեր Շրանկը իրենց "հակատրամաբանական" մոտեցումը նկարագրում է որպես "խառնաշփոթ"[14]։ Ողջամիտ գիտելիքների բազան արհեստական ինտելեկտի "խառնաշփոթի" օրինակ է, քանի որ դրանք ստեղծվում են ձեռքով, մեկ բարդ հասկացություն մեկ անգամ[148]։

Գիտելիքի վրա հիմված

[խմբագրել | խմբագրել կոդը]Երբ 1970-ականներին մեծ հիշողությամբ համակարգիչները դարձան հասանելի, բոլոր երեք ուղղությունների հետազոտողները սկսեցին կառուցել գիտելիքի վրա հիմնված արհեստական ինտելեկտի կիրառություններ[149] Այս «գիտելիքի հեզափոխությունը» հանգեցրեց էքսպերտ համակարգերի մշակմանն ու տեղայնացմանը (առաջարկված Էդվարդ Ֆեյենբաումի կողմից), արհեստական ինտելեկտի առաջին իրոք հաջող ծրագրային ապահովումը[34]։ Բոլոր էքսպերտ համակարգերի կառուցվածքի հիմնական բաղադրիչը գիտելիքների բազան է, որը պարունակում է արհեստական ինտելեկտը ներկայացնող փաստեր և կանոններ[150]։ Գիտելիքի հեղափոխությունը պայմանավորված էր նաև այն գիտակցությամբ, որ արհեստական ինտելեկտի բազում պարզ կիրառություններ կպահանջեն գիտելիքի հսկայական ծավալներ։

Ենթասիմվոլիկ

[խմբագրել | խմբագրել կոդը]1980-ականներին կարծես թե սիմվոլիկ արհեստական ինտելեկտի առաջընթացը կանգ առավ, և շատերը կարծում էին, որ սիմվոլիկ համակարգերը երբեք ի վիճակի չեն լինելու նմանակել մարդկային մտածողության ողջ ընթացքը, հատկապես մեքենայական ընկալումը, ռոբոտները, մեքենայական ուսուցումը և պատկերների ճանաչումը։ Մի շարք հետազոտողներ սկսեցին արհեստական ինտելեկտի կոնկրետ խնդիրների համար դիտարկել "ենթասիմվոլիկ" մոտեցումները[15]։ Ենթասիմվոլիկ մոտեցումները կարողանում են մոտենալ ինտելեկտին առանց գիտելիքի կոնկրետ ներկայացման։

Ներկառուցված ինտելեկտ

[խմբագրել | խմբագրել կոդը]Սա ընդգրկում է ներկառուցված, տեղայնացված, վարքագծի վրա հիմնված և նորագույն արհեստական ինտելեկտը։ Ռոբոտների հարակից դաշտի հետազոտողները մերժեցին սիմվոլիկ արհեստական ինտելեկտը և կենտրոնացան հիմնական տեխնիկական խնդիրների վրա, որոնք ռոբոտներին թույլ կտան շարժվել և գոյատևել[151]։ Նրանց աշխատանքը վերակենդանացրեց վաղ 1950-ականների կիբեռնետիկ հետազոտողների ոչ սիմվոլիկ տեսակետը և նորից մտցրեց կառավարման տեսության օգտագործումը արհեստական ինտելեկտում։ Սա համընկավ կոգնիտիվ գիտությանը հարակից ներառական մտքի թեզիսի զարգացման հետ․ այն գաղափարը, որ բարձր ինտելեկտի համար պահանջվում են մարմնի տարբեր ասպեկտներ (ինչպես շարժումը, ընկալումը և արտացոլումը)։

Զարգացնող ռոբոտների շրջանակներում զարգացնող ուսուցման մոտեցումներ են մշակվում, որոնք ռոբոտներին հնարավորություն են տալիս կուտակել նոր հմտությունների դիրեկտորիաներ, անկախ ինքնագնահատման, իրական ուսուցիչների հետ սոցիալական փոխազդեցության և առաջնորդող մեխանիզմների կիրառման միջոցով (ակտիվ ուսուցում, հասունացում, սիներգիա, և այլն).[152][153][154][155]

Հաշվողական ինտելեկտ և ծրագրային հաշիվ

[խմբագրել | խմբագրել կոդը]Արհեստական նեյրոնային ցանցերի և "կապակցվածության" հանդեպ հետաքրքրությունը վերականգնվեց Դեվիդ Ռումելհարթի և այլոց օգնությամբ 1980-ականների կեսերին[156]։ Արհեստական նեյրոնային ցանցերը ծրագրածին հաշվի օրինակ են, դրանք այն խնդիրների լուծումներն են, որոնք չեն կարող լուծվել լիարժեք տրամաբանական որոշակիությամբ և որտեղ մոտավոր լուծումը հաճախ բավարար է։ Արհեստական ինտելեկտի այլ ծրագրային մոտեցումներ ներառում են անորոշ համակարգեր, էվոլյուցիոն հաշվարկ և շատ վիճակագրական գործիքներ։ Ծրագրային հաշվի կիրառումը արհեստական ինտելեկտի համակարգերում ուսումնասիրվում է հաշվարկային ինտելեկտ գիտական ուղղության կողմից[157]։

Վիճակագրական ուսուցում

[խմբագրել | խմբագրել կոդը]Շատ ավանդական արհեստական ինտելեկտ GOFAI համակարգեր մնացին հատուկ կտորներում, սիմվոլիկ հաշիվը, որ աշխատում էր իրենց սեփական խաղալիք մոդելի վրա, ձախողում էր իրական ընդհանրացված տարբերակում։ Այնուամենայնիվ 1990-ականներին արհեստական ինտելեկտի հետազոտողները կիրառեցին բարդ մաթեմատիկական գործիքներ, այնպիսիք, ինչպիսին AI researchers adopted sophisticated mathematical tools, such as Մարկովի թաքնված մոդելը (HMM), ինֆորմացիոն տեսություն, և Բայեսիան նորմատիվ որոշումների տեսություն համեմատելու կամ միավորելու մրցակցող կառուցվածքները։ ընդհանուր մաթեմատիկական լեզուն բարձրակարգ համագործակցության հնարավորություն տվեց ավելի կայացած բնագավառների հետ (ինչպես մաթեմատիկան, տնտեսագիտությունը կամ գործողությունների հետազոտությունը)։[Ն 4] Compared with GOFAI-ի հետ համեմատած, նոր "վիճագրական ուսուցման" միջոցները, ինչպիսին HMM և նեյրոնային ցանցերն են, շատ պրակտիկ տիրույթներում, ինչպիսին տվյալների որսն է ավելի բարձր ճշգրտության են հասնում, առանց տվյալների բազմության սեմանտիկ հասկացվածության անհրաժեշտության։ Իրական տվյալներով հաջողությունների աճը բերեց տարբեր մոտեցումների համեմատության նկատմամբ ուշադրության աճին՝ համեմատելու թե առաջարկված յուրահատուկ խաղալիք մոդելներից ո՞ր մոտեցումն է լավագույնը ներկայացվում ավելի լայն կոնտեաստում։ Արհեստական ինտելեկտի հետազոտությունները դառնում էին ավելի գիտական։ Ներկայումս փորձերի արդյունքները հաճախ ճշգրիտ չափելի են և երբեմն (դժվարությամբ) վերարտադրելի[35][158]։ Տարբեր վիճակագրական ուսուցման միեթոդներ տարբեր սահմանափակումներ ունեն, օրինակ, հիմնական HMM-ն չի կարող մոդելավորել բնական լեզվի անվերջ հնարավոր կոմբինացիաները։[159] Քննադատները նշում են, որ ավանդական GOFAI-ից շեղվելը դեպի վիճակագրական ուսուցում, հաճախ նաև հեռանալ է բացատրելի արհեստական ինտելեկտից։ Արհեստական ընդհանուր ինտելեկտի հետազոտության մեջ, որոշ գիտնականներ զգուշացնում են վիճակագրական ուսուցումից չափազանց մեծ կախվածությունից, և պնդում, որ GOFAI-ի շարունակական հետազոտությունը դեռևս անհրաժեշտ կլինի ընդհանուր ինտելեկտի հասնելու համար։[160][161]

Մոտեցումների ինտեգրում

[խմբագրել | խմբագրել կոդը]Ինտելեկտուալ ագենտի պարադիգմ։ Ինտելեկտուալ ագենտը համակարգ է, որը ընկալում է իր շրջապատը և գործողություններ է ձեռնարկում, որոնք առավելագույնի են հասցնում հաջողության հնարավորությունը։ Պարզագույն ինտելեկտուալ ագենտներ են յուրահատուկ խնդիրներ լուծող ծրագրերը։ Ավելի բարդ ագենտները ներառում են մարդկանց և մարդկանց կազմակերպությունները (ինչպես բիզնեսները)։ Պարադիգմը հետազոտողներին թույլ է տալիս ուղղակիորեն համեմատել և նույնիսկ միավորել մեկուսածված խնդիների նկատմամբ տարբեր մոտեցումները, հարցնելով, որ ագենտն է լավագույնը տված "նպատակային ֆունկցիան" առավելագույնին հասցնելու մեջ։ Յուրահատուկ պրոբլեմ լուծող ագենտը կարող է օգտագործել աշխատող ամեն մի մոտեցում՝ որոշ ագենտներ սիմվոլիկ կամ տրամանական, որոշները ենթասիմվոլիկ արհեստական նեյրոնային ցանցեր և մյուսները կարող են օգտագործել նոր մոտեցումներ։ Պարադիգմը նաև հետազոտողներին տալիս է ուրիշ բնագավառների հետ շփվելու ընդհանուր լեզու, ինչպիսին են որոշումների տեսությունը, տնտեսագիտությունը, որոնք նույնպես օգտագործում են աբստրակտ ագենտների հասկացությունը։ Ամբողջական ագենտ կառուցելը հետազոտողից պահանջում է լուծել ինտեգրման իրական խնդիրներ, օրինակ, քանի որ սենսորային համակարգերը շրջակա միջավայրի մասին անորոշ տեղեկատվություն են տալիս, պլանավորման համակարգերը պետք է կարողանան գործել անորոշության մեջ։ Ինտելեկտուալ ագենտ պարադիգմը 1990-ականների ընթացքում լայնորեն ընդունվեց[162]։

Ագենտի կառուցվածք և կոգնիտիվ կառուցվածք։ Հետազաոտողները բազմա-ագենտ համակարգերում փոխգործակցող ինտելեկտուալ ագենտներից ինտելեկտուալ համակարգեր կառուցելու համար համակարգեր են մշակել[163]։ Հիերարխիկ կառավարման համակարգը կամուրջ է ապահովում ենթասիմվոլիկ արհեստական ինտելեկտի, դրա ամենացածր ռեակտիվ մակարդակում և ավանդական սիմվոլիկ արհեստական ինտելեկտի, դրա ամենաբարձր մակարդակում, ազատ ժամանակի սահմանափակումները հնարավորություն են տալիս պլանավորել և մոդելավորել աշխարհը[164]։ Որոշ կոգնիտիվ կառուցվածքներ սովորաբար կառուցված են նեղ խնդիրների լուծման համար, ուրիշները մշակված են մարդու իմացությունը նմանակելու և ընդհանուր պատկերացում կազմելու համար։

Գործիքներ

[խմբագրել | խմբագրել կոդը]Արհեստական ինտելեկտը մշակել է մեծ թվով գործիքներ լուծելու ամենաբարդ խնդիրները Ինֆորմատիկայում։ Ստորև բերված են այս մեթոդների ամենատարածվածներից մի քանիսը։

Որոնում և օպտիմիզացիա

[խմբագրել | խմբագրել կոդը]Արհեստական ինտելեկտի շատ խնդիրներ կարող են լուծվել տեսականորեն մտածված փնտրելով բազմաթիվ հնարավոր լուծումների մեջ[165]։ [[#Deduction, reasoning, problem solving|Դատողություն անելը, խնդիր լուծելը կարելի է է իրականացնել որոնմամբ։ Օրինակ, տրամաբանական ապացույցը կարելի է դիտարկել որպես ճանապարհի որոնում, որը նախադրյալից տանում է եզրակացության, որտեղ յուրաքանչյուր քայլ հետևության կանոնի կիրառում է[166]։ Ավտոմատ պլանավորման ալգորիթմները փնտրում են նպատակների և ենթանպատակների ծառի միջով, փորձելով գտնել թիրախային նպատակը, պրոցես, որ կոչվում է միջոցների և նպատակների վերլուծություն[167]։ Վերջույթները շարժելու և առարկաները բռնելու ռոբոտատեխնիկայի ալգորիթմներն օգտագործում են տեղային որոմնումները տարածական կոնֆիգուրացիայում[113]։ Բազմաթիվ մեքենայական ուսուցման ալգորիթմներ օգտագործում են օպտիմիզացիայի վրա հիմնված որոնման ալգորիթմներ։

Պարզ սպառիչ որոնումները[168] իրական աշխարհի խնդիրներին հազվադեպ են բավարարում․ որոնվող տարածքների քանակը աճում է աստղաբաշխորեն։ Արդյունքում որոնումը շատ դանդաղ է ընթանում, կամ երբեք չի ամբողջանում։ Շատ խնդիրների համար լուծումը էվրիստիկան կամ փորձերի կանոններն օգտագործելն է, որոնք ընտրում են ըստ առաջնահերթության որոնք հավանաբար նպատակին կհասցնեն և և դա կանեն քիչ քայլերով։ Որոնման որոշ մեթոդոլոգիաներում էվրիստիկան կարող է օգտագործվել բոլոր ընտրվածների համար, որոնք հազիվ թե հասցնեն նպատակին (կոչվում է որոնման ծառի ծառահատում)։ Էվրիստիկան ծրագրին առաջարկում է "լավագույն ենթադրությունը" լուծման տանող ճանապարհի համար[169]։ Էվրիստիկան լուծումների որոնման քանակը նվազեցնում է։[114]

Որոնման շատ տարբեր տեսակներ ի հայտ եկան 1990-ականներին որոնման շատ տարբեր տեսակներ ի հայտ եկան, որոնք հիմնված էին մաթեմատիկական օպտիմիզացիայի հիման վրա։ Շատ խնդիրների համար, հնարավոր է որոնումը սկսել որոշակի գուշակությամբ և այնուհետ աստիճանաբար ճշգրտել, մինչև այլևս ճշգրտելու կարիք չլինի։ Այս ալգորիթմները կարելի է պատկերացնել որպես կուրորեն բլուր բարձրանալ․ որոնումը սկսում ենք լանդշաֆթի պատահական կետից, այնուհետ ցատքերով կամ քայլերով շարունակում ենք բլուրը բարձրանալ մինչև գագաթ հասնելը։ Այլ օպտիմիզացիոն ալգորիթմներ են այրման իմիտացիան, ճառագայթի որոնումը և պատահական օպտիմիզացիան[170]։

Էվոլյուցիոն հաշվարկն օգտագործում է օպտիմալ որոնումը։ Օրինակ, այն կարող է սկսել օրգանիզմների պոպուլյացիայով (գուշակություններ) և այնուհետ թույլ տալ նրանց մուտացիայի ենթարկվել և վերամիավորվել, արհեստական ընտրություն միայն յուրաքանչյուր սերնդի ամենահարմարվողները կգոյատևեն (ճշգրտելով գուշակությունները)։ Դասական էվոլյուցիոն ալգորիթմները ներառում են գենետիկ ալգորիթմները և գենետիկ ծրագրավորումը[171] Այլապես որոնման բաշխված պրոցեսները կարող են համակարգվել սվորմ ինտելեկտ ալգորիթմների միջոցով։ Երկու հանրահայտ սվորմ ալգորիթմներ օգտագործվում են որոնման մեջ մասնիկների երամի օպտիմիզացիա (ոգեշնչված թռչունների երամվելով) և մրջյունների գաղութի օպտիմիզացման (օգեշնչված մրջյունների արահետներով)[172][173]։

Տրամաբանություն

[խմբագրել | խմբագրել կոդը]Տրամաբանությունն[174] օգտագործվում է գիտելիքի ներկայացման և խնդիրների լուծման համար, սակայն այն կարող է կիրառվել նաև այլ խնդիրների նկատմամբ։ Օրինակ, satplan ալգորիթմը օգտագործում է տրամաբանության ավտոմատ պլանավորման համար[175] և ինդուկտիվ տրամաբանական ծրագրավորման ալգորիթմը մեքենայական ուսուցման ալգորիթմ է[176]։

Տրամաբանության մի քանի տարբեր ձևեր են օգտագործվում Արհեստական ինտելեկտի հետազոտություններում։ Ասույթների տրամաբանությունը[177] ներառում է ճշմարիտ ֆունկցիաներ, ինչպիսիք "կամ"-ը և "ժխտում"-ն են։ Պրեդիկատների տրամաբանությունը[178] ավելացնում է քվանտորներ և պրեդիկատներ և կարող է առարկայի մասին փաստեր ներկայացնել, դրանց հատկությունները և դրանց հարաբերությունները միմյանց հետ։ Կենտ բազմությունների տեսությունը անորոշ արտահայտությունների համար, ինչպիսին, "Ալիսան ծեր է" (կամ հարուստ, կամ բոյով, կամ սոված), որոնք չափից ավելի անորոշ են լիովին ճիշտ կամ սխալ լինելու համար, սահմանում է "ճշմարտության աստիճան" ( 0 և 1-ի միջև)։ Կենտ տրամաբանությունը հաջողությամբ օգտագործվում է կառավարման համակարգերում, որպեսզի էքսպերտներին հնարավորություն տա անորոշ կանոնները, ինչպես "եթե դու մոտ ես նպատակակետին և արագ եք շարժվում, ապա մեծացրեք գնացքի արգելակային տվյալները", այս անորոշ կանոնները այնուհետ կարող են համակարգում քանակապես ճշգրտվել։ Կենտ տրամաբանությունը չի ընդլայնվում գիտելիքների բազայի վրա, շատ Արհեստական ինտելեկտի հետազոտողներ կասկածի տակ են դնում անորոշ տրամաբանական եզրակացությունների հիմնավորումը։ [Ն 5][180][181]}}

Լռելայն տրամաբանությունը, ոչ մոնոտոն տրամաբանությունը և իրավիճակային տրամաբանությունը[89] տրամաբանության ձևեր են, որ մշակվել են օգնելու կանխորոշված հիմնավորումներում և որակավորման խնդիրներում։ Մի քանի ընդլայնումներ մշակվել են ներկայացնելու գիտելիքի յուրահատուկ տիրույթներ, ինչպիսիք են դնսկրիպտիվ տրամաբանությունը[77], Իրավիճակային հաշիվը, պատահարների հաշիվը և սահուն հաշվարկը (պատահարներն ու ժամանակը ներկայացնելու համար)[78] պատճառային հաշվարկը[79], վստահության հաշվարկը[182] 7 մոդալ տրամաբանությունը[80]։

Ընդհանուր առմամբ որակական սիմվոլիկ տրամաբանությունը փխրուն է և աղմուկի առկայության կամ այլ անորոշության դեպքում դժվար է հարմարվում։ Կանոնների բացառությունները բազմաթիվ են, և տրամաբանական համակարգի համար դժվար է գործել իրար հակասող օրենքների առկայության դեպքում։[183][184]

Հավանականության մեթոդներ անորոշ փաստարկների համար

[խմբագրել | խմբագրել կոդը]

Արհեստական ինտելեկտի շատ խնդիրներ (մտահանգումների, պլանավորման, ուսման, ընկալման և ռոբոտների մեջ) ագենտից պահանջում են գործել ամբողջական կամ անորոշ տեղեկության պայմաններում։ Արհեստական ինտելեկտի հետազոտողները այդ պրոբլեմները լուծելու համար, օգտագործելով հավանականության տեսության և տնտեսագիտության մեթոդները, մշակել են մի շարք հզոր գործիքներ[185]։

Բայեսյան ցանցերը[186] շատ ընդհանուր գործիք են, որ կարող են օգտագործվել խատ մեծ թվով խնդիրների համար․ դատողությունների (օգտագործելով բայեսյան եզրակացության ալգորիթմը)[187], մեքենայական ուսուցումը (օգտագործելով սպասումների մաքսիմալիզացիայի ալգորիթմը),[Ն 6][189] Ավտոմատացված պլանավորումը (օգտագործելով որոշումների ցանցերը)[190] և մեքենայական ակնկալումը (օգտագործելով դինամիկ բայեսյան ցանցերը)[191]։ Հավանականական ալգորիթմները կարող են նաև օգտագործվել տվյալների հոսքերի զտման, կանխատեսման, հարթեցման և բացատրությունների որոնման համար, օգնելով մեքենայական ընկալման համակարգերին վերլուծել ժամանակի ընթացքում տեղի ունեցող պրոցեսները (օրինակ, Մարկովի թաքնված մոդելները կամ Կալմանի ֆիլտրերը)[191]։ Սիմվոլիկ տրամաբանության հետ համեմատած ֆորմալ Բայեսյան եզրակացությունները թանկ հաշվարկվող են։ Որպեսզի եզրակացության հետագծին հնարավոր լինի հետևել, բոլոր դիտարկումները մեկը մյուսից պայմանականորեն պետք է անկախ լինեն։ Բարդ գրաֆները շեղանկյուններով կամ այլ "հանգույցներով" (ուղղություն չունեցող ցիկլեր) կարող են պահանջել փորձարկված մեթոդներ, ինչպիսին Մոնտե Կառլոյի Մարկովի շղթան է, որը Բայեսյան ցանցի միջով ցրում է պատահական թափառաշրջիկների համույթը և փորձում է զուգամիտել պայմանական հավանականությունների վարկանիշային գնահատմանը։ Բայեսյան ցանցերը օգտագործվում են Xbox Live-ում խաղացողների վարկանիշային գնահատման համար, հաղթանակներն ու կորուստները "վկայում են" թե որքան լավն է խաղացողը։ AdSense-ն օգտագործում է Բայեսյան ցանցերը ավելի քան 300 միլիոն եզրերով, հասկանալու որ գովազդը ցույց տա[183]։

Տնտեսագիտության առանցքային հասկացություն է "օգտակարությունը"՝ չափը, թե որքան արժեքավոր է ինչ որ բան ինտելեկտուալ ագենտի համար։ Ճշգրիտ մաթեմատիկական գործիքներ են մշակվել, որոնք վերլուծում են ինպես ագենտը, օգտագործելով որոշումների տեսությունը, որոշումների անալիզը և տեղեկատվական արժեքի տեսությունը, կարող է ընտրություն կատարել և պլանավորել[95][192]։ Այս գործիքներից են Մարկովի որոշումների պրոցեսը[193], դինամիկ որոշումների ցանցերը[191], խաղերի տեսությունը և մեխանիզմի մշակումը[194]։

Դասակարգիչներ և վիճակագրական ուսուցման մեթոդներ

[խմբագրել | խմբագրել կոդը]Արհեստական ինտելեկտի պարզագույն կիրառությունները կարող են բաժանվել երկու տիպի․ դասակարգիչներ ("եթե փայլլում է, ապա ադամանդ է") և կարգավորիչներ ("եթե փայլում է, ապա վերցրեք")։ Կարգավորիչներն իրականացնում են, այնուամենայնիվ, մինչև եզրակացություններ անելը․ դասակարգում են պայմանները, հետևաբար դասակարգումը կազմում է բազում ԱԻ համակարգերի կենտրոնական մասը։ Դասակարգիչները, դրանք ֆունկցիաներ են, որոնք նմուշի հետ համեմատելն օգտագործում են ամենահամընկնողը գտնելու համար։ Դրանք կարող են հարմարեցվել ըստ օրինակների, դարձնելով շատ գրավիչ ԱԻ-ում օգտագործման համար։ Այս օրինակները հայտնիեն որպես դիտարկումներ կամ նմուշներ։ Վերահսկվող ուսուցման մեջ յուրաքանչյուր շաբլոն պատկանում է որոշակի նախապես սահմանված դասի։ Դասը կարող է դիտվել որպես որոշում, որը պետք է կայացվի։ Բոլոր դիտարկումները միասին իրենց դասի պիտակների հետ միասին հայտնի են որպես տվյալների բազմություն։ Երբ նոր դիտարկում է ստացվում, այն դասակարգվում է նախկին փորձի հիման վրա[195]։

Դասակարգիչը կարող է վերապատրաստվել տարբեր եղանակներով․ կան բազմաթիվ վիճակագրական և մեքենայական ուսուցման մեթոդներ։ Հավանաբար, որոշումների ծառը[196] ամենատարածված մեքենայական ուսուցման ալգորիթմն է։[197] Այլ լայն տարածում ունեցող դասակարգիչներ են նեյրոնային ցանցերը[198], [[k-ամենամոտ հարևան ալգորիթմը,[Ն 7][200] կեռնելի մեթոդները, ինչպիսիք են աջակցության վեկտորային մեքենան,(SVM),[Ն 8][202] Գաուսյան խառնուրդի մոդելը[203], և չափազանց տարածված նաիվ Բայեսյան դասակարգիչը։[Ն 9][205] Դասակարգչի արդյունավետությունը մեծապես կախված է դասակարգվող տվյալների բնութագրիչներից, այսպես օրինակ, տվյալների բազմության չափը, նմուշների բաշխվածությունը դասերի, ծավալը և աղմուկի մակարդակը։ Մոդելի վրա հիմնված դասակարգիչները լավ են աշխատում, եթե ենթադրվող մոդելը մեծագույնս համապատասխանում է իրական տվյալներին։ Հակառակ դեպքում, եթե համապատասխան մոդել չկա, և եթե ճշգրտությունը միակ խնդիրն է, խելամիտ է համարվում օգտվել տարբերակող դասակարգիչներից, որոնք իրական տվյալների բազմությունների մեծ մասի վրա ավելի ճշգրիտ են, քան մոդելի վրա հիմնված դասակարգիչները, ինչպիսին "նաիվ Բայեսն է" իրական տվյալների բազմությունների մեծ մասի վրա[206]։[207]

Արհեստական նեյրոնային ցանցեր

[խմբագրել | խմբագրել կոդը]

Նեյրոնային ցանցերը ստեղծվել են մարդու ուղեղի կառուցվածքով ոգեշնչվելով։ Պարզ "նեյրոնը" N մուտքեր է ընդունում բազմաթիվ այլ նեյրոններից, որոնցից յուրաքանչյուրը N նեյրոնի ակտիվացման (կամ "հեռացման") օգտին կամ դեմ կշռադատված "ձայն" է տալիս։ Ուսումնառությունը պահանջում է ալգորիթմ, որը վերապատրաստման տվյալների հիման վրա կկարգավորի կշիռները։ Մի պարզ ալգորիթմ է՝ Հեբիան ուսուցումը, դա կշռի բարձրացումն է, երբ երկու հարակից նեյրոնների մեկի ակտիվացման դեպքում, ակտիվանում է նաև մյուսը։ Ցանցը ձևավորում է "հասկացություններ" որոնք բաշխված են ընդհանուր նեյրոնների ենթացանցում,[Ն 10] որոնք հակված են միասին գործելուն, "ծունկ" հասկացությունը կարող է միավորվել "ոտք" իմաստ ունեցող ենթացանցին, որը ներառում է "ոտքի" ձայնը։ Նեյրոններն ունեն ակդիվացման շարունակական սպեկտր, բացի այդ նեյրոնները կարող են մուտքային տվյալներ մշակել ոչ գծային եղանակով, այլ ոչ թե համեմատել ուղիղ ձայներով։ Ժամանակակից նեյրոնային ցանցերը կարող են սովորել երկուսն էլ անընդհատ ֆունկցիաները և, ի զարմանս թվային տրամաբանական գործողությունները։ Նեյրոնային ցանցերի վաղ ձեռքբերումները ներառում էին ֆոնդային շուկայի կանխատեսումը և (1995) հիմնականում ինքնակառավարվող ավտոմեքենան։[Ն 11][208] 2010-ականներին, խորը ուսուցումն օգտագործող նեյրոնային ցանցերի ձեռքբերումները Արհեստական ինտելեկտ հասցրին լայն հասարակական գիտակցության և արհեստական ինտելեկտի ոլորտին ուղղված կորպորատիվ ֆինանսավորման հսկայական խթանման, օրինակ ԱԻ-ին ուղղված 2017 թվականի ծախսերը 25 անգամ գերազանցեցին 2015-ի ծախսերին[209][210]։

Ոչ ուսուցման նեյրոնային ցանցերի ուսումնասիրությունը սկսվել է[198] Արհեստական ինտելեկտի ոլորտը հայտնաբերելուց տասնամյակ առաջ Վալտեր Պիտցի և Ուորեն Մաքկալոկի աշխատանքներում։ Ֆրանկ Ռոզենբլատտը հայտագործեց պերսեպտրոնը, մեկ շերտով ուսումնառության ցանցը, նման գծային ռեգրեսիայի հին հասկացությանը։ Վաղ ռահվիրաններից են նաև Ալեքսեյ Գրիգորևիչ Իվախնենկոն, Տեյվո Կոհոնենը, Ստեֆեն Գրոսբերգը, Կունիհիկո Կուկուշիման, Քրիստոֆ վոն դեր Մալսբուրգը, Դավիթ Վիլշոուն, Չան Ինչ Ամարին, Բեռնարդ Վիդրոուն, Ջոն Հոպֆիլդը, Էդուարդո Կայանյելոն և ուրիշներ։

Ուղիղ կապով խոր նեյրոնային ցանցեր

[խմբագրել | խմբագրել կոդը]Խորն ուսումնառությունը արհեստական նեյրոնային ցանց է, որը կարող է սովորել պատճառահետևանքային կապերի։երկար շղթա։ Օրինակ, վեց թաքնված շերտերով առաջ տանող ցանցը կարող է սովորել յոթ պատճառահետևանքային կապերով շղթան (վեց թաքնված շերտ և ելքային շերտ) և ունի յոթ խորությամբ վարկային հանձնարարության ուղի "credit assignment path" (CAP)։ Շատ խորն ուսուցման համակարգերը պետք է ի վիճակի լինեն սովորել և ունենալ տաս կամ ավելի երկարությամբ պատճառահետևանքային կապերի շղթա[211] Խորն ուսումնառությունը ձևափոխեց արհեստական ինտելեկտի շատ կարևոր ենթաոլորտներ, ներառյալ համակարգչային տեսողություն, խոսքի ճանաչում, բնական լեզվի մշակում և այլն[211][212][213]։

Համաձայն մի ակնարկի[214], "Խորն ուսուցում" արտահայտությունը ներկայացվել է մեքենայական ուսուցման հանրությանը 1986 թվականին Ռինա Դեխտերի կողմից[215] և թափ է առել 2000 թվականին, Իգոր Այզենբերգի և նրա գործընկերների կողմից այն որպես Արհեստական նեյրոնային ցանցեր առաջարկելուց հետո[216]։ Առաջին ֆունկցիոնալ խորն ուսումնառության ցանցերը հրապարակվել են 1965 թվականին Ալեքսեյ Իվախնենկոյի և Լապայի կողմից[217][Հղում աղբյուրներին] Այս ցանցերը մեկ մոտեցմամբ մեկ մակարդակ են յուրացնում։ Իվախնենկոյի 1971 թվականի հոդվածը[218]։ նկարագրում է ուղիղ կապով, ութ շերտանի խորությամբ ուսումնառության պերսեպտրոն, որը, արդեն իսկ, շատ ավելի խորն էր, քան հետագա շատ ցանցեր։ Ջեֆրի Հինտոնի և Ռուսլան Սալախուդինովի 2006 թվականին հրապարակեցին բազմաշերտ ուղիղ կապով նեյրոնային ցանցերի նախապատրաստման այլ եղանակ։ Այն, մեկ մակարդակ մեկ մոտեցմամբ, յուրաքանչյուր մակարդակը դիտարկում է որպես չվերահսկվող Բոլցմանի սահմանափակ մեքենա, այնուհետ օգտագործելով վերահսկվող հետադարձ տարածումը, լավ կարգավորել։[219] Մակերեսային արհեստական նեյրոնային ցանցերի նման խորը նեյրոնային ցանցերը կարող են մոդելավորել բարդ ոչ գծային հարաբերություններ։ Վերջին տարիների առաջընթացը մեքենայական ուսուցման ալգորիթմներում և համակարգիչների սարքային ապահովման մեջ տարան ավելի արդյունավետ մեթոդների խորը նեյրոնային ցանցերի վերապատրաստման համար, որոնք ներառում են ոչ գծային թաքնված էլեմենտների բազմաթիվ շերտեր և շատ մեծ ելքային շերտ[220]։

Խոր ուսուցումը հաճախ օգտագործում է փաթեթային նեյրոնային ցանցեր, որոնք սկիզբ են առնում 1980 թվականին Ֆուկուշիմայի ստեղծած նեոկոգնիտրոնից[221]։ 1989 թվականին Յան Լեկունը գործընկերների հետ այսպիսի կառուցվածքի նկատմամբ կիրառեց սխալը գտնելու ետ տարածման մեթոդը։ Վաղ 2000-ականներին, CNN-ների արդյունաբերական կիրառումը արդեն իսկ գնահատվում էր ԱՄՆ-ում գրված չեկերի 10% - 20% -ը[222]։ 2011-ից ի վեր, fast implementations of CNN-ների արագ կիրառումները GPU-ների վրա, հաղթեցին վիզուալ շաբլոնի ճանաչման մրցույթներում[211]։

12 փաթեթային շերտերով CNN ցանցերը ամրապնդող ուսուցման հետ օգտագործվում էին Deepmind-ի "AlphaGo Lee" ծրագրում, որը 2016 թվականին հաղթեց Գո խաղի չեմպիոնին[223]։

Խոր պարբերական նեյրոնային ցանցեր

[խմբագրել | խմբագրել կոդը]Սկզբում խորն ուսումառությունը կիրառվում էր նաև պարբերական նեյրոնային ցանցերով (RNNs) հաջորդական ուսումնառության նկատմամբ[224], որն ամբողջականացվել է Թյուրինգի տեսությունում[225] և մուտքային տվյալների կամայական հաջորդականության մշակման համար կարող են իրականացնել կամայական ծրագրեր։ RNN-ի խորությունը անսահմանափակ է և կախված է մուտքի հաջորդականության երկարությունից, այսպիսով RNN-ը խորն ուսումնառության օրինակ է[211] RNN-ները կարող են սովորել գրադիենտի անկմամբ[226][227][228],։ սակայն թույլ են տալիս գրադիենտի խնդրի անհետացում[212][229]։ 1992 թվականին ցույց է տրվել, որ պարբերական նեյրոնային ցանցերի ստեկի անվերահսկելի նախապատրաստումը կարող է արագացնել խորը հաջորդական խնդիրների հետագա վերահսկողական ուսումնասիրությունը[230]։

Բազմաթիվ հետազոտողներ այժմ օգտագործում են խոր ուսուցման պարբերական նեյրոնային ցանցերի տարբերակներ, որ կոչվում են երկար կարճաժամկետ հիշողության ցանց (LSTM), հրապարակված 1997 թվականին Hochreiter & Schmidhuber-ի կողմից[231]։ LSTM-ն is often trained by Connectionist Temporal Classification (CTC).[232] Այս մոտեցումը խոսքի ճանաչման մեջ հեղափոխություն իրականացրեց Google-ում, Microsoftում և Baidu-ում[233][234][235]։ Օրինակ, 2015 թվականին, LSTM Google-ի խոսքի ճանաչումն աճեց 49% CTC-ուսուցման միջոցով, որն այժմ հասանելի է Google Voice-ի միջոցով միլիարդավոր սմարթֆոնի օգտվողներին[236]։ Google-ը LSTM-ն օգտագործվում է նաև մեքենայական թարգմանությունը[237], լեզվի մոդելավորումը[238] և բազմալեզու լեզվական մշակումը բարելավելու համար[239]։ LSTM-ը CNN-ների հետ նաև զարգացրել են պատկերի ավտոմատ նկարագրության ստեղծումը[240] և բազում այլ կիրառություններ։

Առաջընթացի գնահատում

[խմբագրել | խմբագրել կոդը]Արհեստական ինտելեկտը, ինչպես էլեկտրաէներգիան կամ գոլորշու շարժիչը, ընդհանուր նշանակության տեխնոլոգիա է։ Չկա միակարծություն, թե ինչպես բնութագրել խնդիրները, որոնցում ԱԻ-ն ձգտում է աչքի ընկնել[241]։ Մինչ ծրագրերը, ինչպիսին AlphaZero-ն է, հաջողեցին զրոյից իրենց սեփական գիտելիքները գեներացնել, շատ այլ մեքենայական ուսուցման ծրագրեր պահանջում են վերապատրաստման մեծ հավաքածուներ[242][243]։ Հետազոտող Էնդրյու Ինը որպես "ծայրահեղ անկատար բթամտի կանոն" է առաջարկել, որը "համարյա ամեն ինչ, որ սովորական մարդը մտքում կարող է անել մի վայրկյանից քիչ ժամանակում, հավանաբար այժմ կամ մոտ ապագայում կարող ենք ավտոմատացնել արհեստական ինտելեկտ օգտագործելով։"[244] Մորավեկի պարադոքսը ենթադրում է, որ ԱԻ-ն զիջում է մարդուն շատ հարցերում, որ մարդկային ուղեղը հատկապես զարգացած է լավ գործելու համար[119]։

Առաջընթացի ցուցանիշների գնահատման համար, խաղերն ապահովում են լավ հրապարակված չափորոշիչներ։ Մոտավորապես 2016 թվականին AlphaGo-ն դասական խաղատախտակային խաղերի դարաշրջանն ավարտեց։ Ոչ ատարյալ գիտելիքի խաղերը նոր մարտահրավերներ են դնում խաղերի տեսության արհեստական ինտելեկտի բնագավառում[245][246]։ Կիբեռսպորտ խաղերը, ինչպիսին StarCraft-ն է շարունակում է լրացուցիչ հանրային ցուցանիշներ ապահովել[247][248]։ Արհեստական ինտելեկտում հետազոտությունը խթանելու համար, բազմաթիվ մրցույթներ և մրցանակներ գոյություն ունեն։ Մրցույթների ամենատարածված բնագավառները ներառում են մեքենայական ընդհանուր ինտելեկտը, խոսակցական վարքագիծ, տվյալների վերլուծություն, ինքնակառավարվող ավտոմեքենաներ, ռոբոտների ֆուտբոլ, ինպես նաև սովորական խաղեր[249]։

"Իմիտացիոն խաղ" (1950 թվականի Թյուրինգի թեստի մեկնաբանումը, որը գնահատում է արդյոք համակարգիչը կարող է նմանակել մարդուն) այսօր դիտարկվում է շատ կիրառելի որպես իմաստալից չափանիշ[250]։ Թյուրինգի թեստից ածանցյալ, Ամբողջովին Ավտոմատացված Թյուրինգի Հանրային թեստը ներկայացնում է համակարգիչն ու մարդն առանձին։ (CAPTCHA). Ինչպես անունից է հետևում այն օգնում է որոշել օգտվողը մարդ է, թե մարդուն նմանակող համակարգիչ։ Ի տարբերություն Թյուրինգի ստանդարտ թեստի, CAPTCHA-ն կառավարվում է մեքենայի կողմից և ուղղված է դեպի մարդը, այլ ոչ թե մարդու կողմից կառավարվող և ուղղված մեքենային։ Համակարգիչը օգտվողին լրացնելու պարզ թեստ է առաջարկում, ապա գնահատում է այն։ Կոմպյուտերներն ի վիճակի չեն լուծել խնդիրը, ուստի ճշգրիտ լուծումը համարվում է թեստն անցած մարդու արդյունքը։ CAPTCHA-ի տարածված թեստի տեսակն է, որ պահանջում է ծռմռված տառերի, թվերի կամ նշանների մուտքագրումը, որոնք հայտնվում են էկրանին, համակարգչի կողմից չվերծանվող պատկերով։[251]

Առաջարկվող "ունիվերսալ ինտելեկտի" թեստերը նպատակուղղված են համադրելու, թե որքան լավ են մեքենաները, մարդիկ, և նույնիսկ կենդանիներն աշխատում հնարավորինս ընդհանուր խնդիրների բազմության վրա։ Ծայրահեղ դեպքում թեստերի հավաքածուն կարող է պարունակել Կալմոգորովի բարդությամբ գնահատված բոլոր հնարավոր խնդիրները, ցավոք, այս խնդիրների բազմություններում գերիշխում են աղքատացած շաբլոնին համեմատվող վարժությունները, որտեղ կարգավորվող ԱԻ-ն հեշտությամբ կարող է գերազանցել մարդու կատարողականի մակարդակը[252][253]։

Կիրառություններ

[խմբագրել | խմբագրել կոդը]

Արհեստական ինտելեկտը վերաբերում է յուրաքանչյուր ինտելեկտուալ խնդրի։[254] Ժամանակակից արհեստական ինտելեկտի միջոցները շատ տարածված են և շատ են այստեղ բոլորը թվարկելու համար։ Հաճախ, երբ տեխնիկան դառնում է հիմնական օգտագործվող, այն այլևս չի համարվում արհեստական ինտելեկտ, այս երևույթը դիտարկվում է որպես արհեստական ինտելեկտի ազդեցություն։[255]

Արհեստական ինտելեկտի բարձրակարգ նմուշներ են ինքնակառավարվող փոխադրամիջոցները (ինչպիսիք են անօդաչու թռչող սարքերը և ինքնակառավարվող մեքենաները), բժշկական ախտորոշումը, արվեստի գործերի ստեղծումը (ինչպես պոեզիան), մաթեմատիկական թեորեմների ապացուցումը, խաղեր խաղալը (շախմատ ու գո), որոնողական համակարգեր (Գուգլ (որոնողական համակարգ)), առցանց օգնական (Siri), լուսանկարներում պատկերների ճանաչումը, սպամի ֆիլտրումը, թռիչքի հետաձգման կանխատեսումը[256], դատական որոշումների կանխատեսումը[257] և առցանց գովազդներին ուշադրություն դարձնելը։[254][258][259]

Քանի որ սոցիալական լրատվամիջոցները որպես լուրերի աղբյուր երիտասարդների համար անցնում են հեռուստատեսությանը, իսկ նորությունների գործակալությունները լուրերի տարածումը գեներացնելու համար ավելի շատ են հիմնվում սոցիալական մեդիա հարթակների վրա[260], հրատարակիչների մեծ մասը պատմություններն ավելի արդյունավետ ուղարկելու համար և տարածման մեծ ծավալ գեներացնելու համար այժմ օգտագործում են արհեստական ինտելեկտի (ԱԻ) տեխնոլոգիաները[261]։

Առողջապահություն

[խմբագրել | խմբագրել կոդը]

ԱԻ-ն կիրառվում է թանկարժեք պրոբլեմի՝ դեղաչափերի որոշման խնդիրների վրա, ենթադրվում է, որ ԱԻ-ի կիրառումը կարող է խնայել 16 միլիարդ դոլար։ 2016 թվականին նորարական ուսումնասիրությունները Կալիֆորնիայում գտել են, որ ԱԻ-ի օգնությամբ մշակված մաթեմատիկական բանաձևերը ճշգրիտ որոշում են մարդու օրգաններին տրվող դեղերի ճշգրիտ չափաբաժինները[262]։

Արհեստական ինտելեկտը ներխուժում է բժշկության ոլորտ օգնելու բժիշկներին։ Համաձայն Bloomberg Technology-ի, Microsoft-ը մշակել է ԱԻ, որն օգնում է բժիշկներին բուժել քաղցկեղը[263]։ Քաղցկեղին վերաբերող հսկայական քանակությամբ հետազոտություններ և դեղեր են մշակվել։ Մանրամասն, քաղցկեղի բուժման համար գոյություն ունեն ավելի քան 800 դեղորայք և պատվաստանյութեր։ Սա բացասաբար է ազդում բժիշկների վրա, քանի որ ընտրության շատ մեծ թվով տարբերակներ կան, ինչը ավելի է դժվարացնում ճիշտ դեղն ընտրել հիվանդի համար։ Microsoft-ը աշխատում է "Hanover" անվամբ մեքենայի մշակման ծրագրի վրա։ Դրա նպատակն է հիշել քաղցկեղին անհրաժեշտ բոլոր փաստաթղթերը, օգնելու կանխատեսել դեղերի որ համադրություններն ամենաարդյունավետը կլինի յուրաքանչյուր հիվանդի համար։ Ներկայումս աշխատում են մյելոիդ լեյկեմիայի՝ մահացու քաղցկեղի, դեմ պայքարի ծրագրի վրա, որի բուժումը տասնամյակների ընթացքում չի բարելավվել։ Մեկ այլ ուսումնասիրություն փաստում է, որ մաշկի քաղցկեղը հայտնաբերելու գործում արհեստական ինտելեկտը նույնքան լավ է, որքան պատրաստված բժիշկները[264]։ Մեկ այլ ուսումնասիրություն արհեստական ինտելեկտն օգտագործում է վերահսկելու բազում բարձր ռիսկային հիվանդներին, և դա իրագործվել է յուրաքանչյուր հիվանդին բազմաթիվ հարցեր տալով, որոնք կազմվելեն բժիշկ հիվանդ կենդանի շփումների հիման վրա[265]։ Մեկ ուսումնասիրություն կատարվել է ուսուցման փոխանցմամբ, մեքենան նույնքան հաջող է ախտորոշում, որքան լավ պատրաստված ակնաբույժը և ավելի քան 95% տոկոս ճշգրտությամբ, կարող է 30 որոշում կայացնել, արդյոք հիվանդին պետք է բուժման ուղարկել[266]։

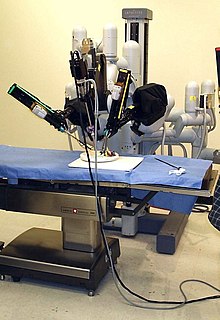

Ըստ CNN-ի վիրաբույժների վերջին հետազոտությունները Վաշինգտոնի մանկական ազգային բժշկական կենտրոնում, հաջողությամբ ցուցադրեցին վիրահատություն ավտոմատ ռոբոտի կողմից։ Թիմը հետևում էր ռոբոտին, երբ նա փափուկ հյուսվածքների վիրահատություն էր կատարում, բաց վիրահատության ժամանակ կարելով խոզի երիկամը և դա անում էր մարդ վիրաբույժից լավ։ IBM ստեղծել է արհեստական ինտելեկտով իր սեփական համակարգիչը, IBM Watson, որը գերազանցել է մարդու ինտելեկտը (որոշ մակարդակներում)։ Watson-ը ոչ միայն հաղթեց Jeopardy! խաղի նախկին չեմպիոններին[267], այլ նաև հերոս հայտարարվեց, լեյկեմիայով հիվանդ կնոջն ախտորոշելուց հետո[268]։

Ավտոմոբիլային

[խմբագրել | խմբագրել կոդը]Արհեստական ինտելեկտի առաջընթացը նպաստել է ավտոմոբիլային արդյունաբերության զարգացմանը ինքնագնաց ավտոմեքենաների ստեղծման և զարգացման միջոցով։ 2016 թվականի տվյալներով, ավելի քան 30 ընկերություններ օգտագործում են ԱԻ-ն ինքնագնաց ավտոմեքենաներ ստեղծելու համար։ Արհեստական ինտելեկտով զբաղվող երեք ընկերություններ` Tesla, Google և Apple, ներառված են ինքնագնաց մեքենաներ ստեղծելու մեջ[269]։

Բազմաթիվ բաղադրիչներ են նպաստում ինքնակառավարվող ավտոմեքենաների գործունեությանը։ Այս տրանսպորտային միջոցները միավորում են այնպիսի համակարգեր, ինչպիսիք են արգելակումը, գոտիների փոփոխությունը, բախման կանխարգելումը, նավիգացիան և քարտեզագրումը։ Այս համակարգերը բարձր արդյունավետության համակարգիչների հետ միասին ինտեգրվում են մեկ բարդ տրանսպորտային միջոցի մեջ[270]։

Վերջին զարգացումներն ինքնավար ավտոմոբիլներում դարձրել են ինքնակառավարվող բեռնատարների նորարարությունը հնարավոր, չնայած դրանք դեռևս փորձարկման փուլում են։ Միացյալ Թագավորության կառավարությունը օրենք է ընդունել, որով 2018 թվականին սկսվելու են ինքնագնաց բեռնատարների դասակների փորձարկումները[271]։ Ինքնակառավարվող բեռնատարների դասակները ինքնագնաց բեռնատարների պարկ են, որ հետևում են մեկ ոչ ինքնակառավարվող առաջատար բեռնատարի, այսպիսով բեռնատար դասակները դեռևս ամբողջովին ավտոմատացված չեն։ Մինչդեռ Daimler գերմանական ավտոմոբիլային ընկերությունը փորձարկում է կիսաավտոմատ բեռնատար, որը միայն կօգտագործվի մայրուղիների վրա[272]։

Հիմնական գործոնը, որն ազդում է ինքնակառավարվող ավտոմոբիլի գործունեության վրա, քարտեզագրումն է։ Ընդհանուր առմամբ մեքենան նախապես ծրագրավորված կլիներ վարման տարածքի քարտեզին համապատասխան։ Այս քարտեզը կներառեր փողոցային լույսի և անհարթությունների մոտեցման մասին տվյալներ, որպեսզի մեքենան տեղյակ լինի իր շրջապատից։ Համենայն դեպս, Google-ն աշխատում է ալգորիթմի վրա, ստեղծելով սարք, որը տարբեր նոր միջավայրերի կկարողանար հարմարվել, որպեսզի վերացնի նախապես ծրագրավորված քարտեզների կարիքը[273]։ Որոշ ինքնակառավարվող մեքենաներ հագեցած չեն ղեկով կամ արգելակման շարժիչներով, հետևաբար հետազոտություն է կատարվել այնպիսի ալգորիթմ ստեղծելու, որն ի վիճակի է ուղևորների անվտանգությունն ապահովել, արագության և վարորդական պայմանների մասին իրազեկման միջոցով[274]։

Մեկ այլ գործոն, որը ազդում է ինքնակառավարվող մեքենայի վրա, ուղևորների անվտանգության ապահովումն է։ Անվարորդ ավտոմեքենա ստեղծելու համար ինժեներները պետք է ծրագրավորեն այն բարձր ռիսկայնության իրավիճակների կարգավորման համար։ Այս իրավիճակները կարող են ներառել հետիոտնի հետ դեմ առ դեմ բախումը։ Ավտոմեքենայի հիմնական նպատակը պետք է լինի այնպիսի որոշում կայացնելը, որը հետիոտնին հարվածելուց խուսափի և ուղևորներին չվնասի։ Բայց հնարավոր է իրադրություն, երբ մեքենայի որոշումը մեկնումեկին վտանգի է ենթարկում։ Այլ կերպ ասած, մեքենան պետք է որոշի` խնայել հետիոտնին, թե ուղևորին[275]։ Ավտոմեքենայի ծրագրավորումն այսպիսի իրավիճակներում վճռորոշ է հաջող ինքնակառավարվող մեքենայի համար։

Ֆինանսներ և տնտեսություն

[խմբագրել | խմբագրել կոդը]Ֆինանսական հաստատությունները վաղուց օգտագործում են արհեստական նեյրոնային ցանց համակարգերը հայտնաբերելու նորմայից դուրս ծախսերը կամ բողոքները և առանձնացնելու մարդկային հետազոտման համար։ ԱԻ-ի օգտագործումը բանկային համակարգում կարելի է դիտարկել 1987 թվականին, երբ Security Pacific National Bank-ը ԱՄՆ-ում ստեղծում է խարդախության կանխարգելման գործառույթ, որը կբացառի դեբետային քարտերի չլիազորված օգտագործումը։ Կասիստո և Moneystream նման ծրագրերը ֆինանսական ծառայություններում օգտագործում են ԱԻ-ն։

Ներկայումս բանկերն արհեստական ինտելեկտ համակարգերն օգտագործում են գործառույթներ իրականացնելու, հաշվապահություն վարելու, բաժնետոմսեր ձեռքբերելու և սեփականության կառավարման համար։ ԱԻ-ն կարող է փոփոխություններին արագ արձագանքել կամ երբ գործարք տեղի չի ունենում[276]։ 2001 թվականի օգոստոսին ռոբոտները հաղթեցին մարդկանց ֆինանսական առևտրի նմանակման մրցույթում[277]։ ԱԻ-ը նաև նվազեցրել է խարդախության և ֆինանսական հանցագործությունների դեպքերը, հետևելով օգտվողների վարքագծային մոդելներին, նորմայից դուրս դրսևորումներն ամրագրելով[278]։

ԱԻ մեքենաների օգտագործումը շուկայում, կիրառություններում, օրինակ առցանց առևտրում և որոշումների կայացման մեջ փոխել է հիմնական տնտեսական տեսությունները[279]։ Օրինակ, AI- ի գնման և վաճառքի պլատֆորմները փոխել են առաջարկի և պահանջարկի օրենքը, որով այժմ հեշտությամբ հնարավոր է գնահատել անհատականացված պահանջարկի և մատակարարման կորերը, հետևաբար և անհատականացված գնագոյացումը։ Բացի այդ ԱԻ մեքենաները նվազեցնում են ինֆորմացիոն ասիմետրիան շուկայում, դարձնելով շուկաներն ավելի արդյունավետ, միաժամանակ նվազեցնելով գործարքների ծավալը։ Ավելին, ԱԻ-ն շուկաներում սահմանափակում է շուկաների վարքագծի հետևանքները, կրկին շուկան ավելի արդյունավետ դարձնելով։ Այլ տեսություններ, որտեղ ԱԻ-ն ազդեցություն է ունեցել, ներառում են ռացիոնալ ընտրության տեսությունը, ռացիոնալ սպասումների տեսությունը, խաղերի տեսությունը, Լյուիսի շրջադարձային կետի, պորտֆելի օպտիմիզացիան և հակափաստարկ մտածողությունը։

Կառավարություն

[խմբագրել | խմբագրել կոդը]Տեսախաղեր

[խմբագրել | խմբագրել կոդը]Տեսախաղերում արհեստական ինտելեկտը սովորաբար օգտագործվում է ոչ խաղացող կերպարների (NPCs) մոտ դինամիկ նպատակասլաց վարք գեներացնելու համար։ Բացի այդ լավ հասկանալի ԱԻ մեթոդները սովորաբար օգտագործվում են ճանապարհի որոնման համար։ Որոշ հետազոտողներ NPC ԱԻ-ն խաղերի մեջ արդյունաբերական խնդիրների մեծ մասի համար համարում են "լուծված պրոբլեմ"։ Ավելի ոչ տիպիկ խաղեր են Left 4 Dead-ի (2008) ԱԻ-ռեժիսորը և դասակների նեյրոէվոլյուցիոն վերապատրաստումը Supreme Commander 2 (2010).[280][281]

Ռազմական ուժեր

[խմբագրել | խմբագրել կոդը]Ռոբոտատեխնիկայի վրա ամենամյա տարեկան ծախսերն աշխարհում 5.1 միլիարդ ԱՄՆ դոլարից 2010 թվականին հասել է 7.5 միլիարդի 2015 թվականին[282][283]։ Ռազմական անօդաչու սարքերը լայն տարածում ունեն։ 2017 թվականին Վլադիմիր Պուտինը հայտարարեց "Ով էլ որ դառնա առաջատար արհեստական ինտելեկտում, նա էլ կդառնա աշխարհի տիրակալ"[284][285]։ Արհեստական ինտելեկտի շատ հետազոտողներ ձգտում են հեռու մնալ ԱԻ-ի ռազմական կիրառություններից[286]։

Աուդիտ

[խմբագրել | խմբագրել կոդը]Արհեստական ինտելեկտը հնարավոր է դարձնում ֆինանսական հաշվետվության մշտական աուդիտը։ ԱԻ գործիքները կարող են վերլուծել տարբեր ինֆորմացիայի հավաքածուներն անմիջապես։ Պոտենցիալ օգուտը կլինի ընդհանուր աուդիտորական ռիսկերը նվազեցնելը, վստահության մակարդակը կաճի և աուդիտի տևողությունը կնվազի[287]։

Գովազդ

[խմբագրել | խմբագրել կոդը]Հնարավոր է ԱԻ-ն օգտագործել կանխագուշակելու կամ ընդհանրացնելու հաճախորդների վարքագիծը իրենց թվային հետքով, որպեսզի ուղղորդել նրանց անհատականացված խրախուսման ակցիաներ կամ ավտոմատ ստեղծել հաճախորդների նախընտրությունների ցանկ[288]։ Փաստաթղթերը հաստատում են, որ առցանց խաղերով զբաղվող կազմակերպություններն ԱԻ-ն օգտագործում են հաճախորդներին նպատակաուղղելու համար[289]։

Ավելին, անհատականության հաշվարկի ԱԻ մոդելների կիրառումը կարող է նպաստել գովազդային արշավների արժեքի նվազեցմանը, ավելացնելով հոգեբանական թիրախը ավանդական սոցիոդեմոգրաֆիկ կամ վարքային թիրախավորմանը[290]։

Արվեստ

[խմբագրել | խմբագրել կոդը]Արհեստական ինտելեկտը բազմաթիվ ստեղծագործական կիրառություններ է ոգեշնչել, ներառյալ դրանց օգտագործումը վիզուալ արվեստ ստեղծելու գործում։ "Մտածող մեքենաներ․ Արվեստ և դիզայն 1959–1989 կոմյուտերային թվերին" ցուցահանդեսը MoMA-ում[291] ներկայացնում է ԱԻ-ի պատմական կիրառությունների լավ ակնարկ արվեստում, ճարտարապետության և դիզայնի մեջ։ Արվեստ ստեղծող ԱԻ-ի օգտագործումը ցուցադրող վերջին ցուցահանդեսները, ներառյալ Google-ի հովանավորությամբ աուկցիոնը Գրեյ Արեա Հիմնադրամում, Սան Ֆրանցիսկո, որտեղ նկարիչները փորձեր էին անում deepdream ալգորիթմով[292] և "Unhuman: Արվեստը ԱԻ-ի դարաշրջանում," ցուցահանդեսը, որը տեղի ունեցավ Լոս Անջելեսում և Ֆրանկֆուրտում 2017 թվականի աշնանը[293][294]։ 2018 թվականի գարնանը Հաշվողական տեխնիկայի ասոցիացիան ամսագրի հատուկ համար է թողարկել նվիրված համակարգիչներ և արվեստ թեմային, ընդգծելով մեքենայական ուսուցման դերը արվեստում[295]։

Փիլիսոփայություն և Էթիկա

[խմբագրել | խմբագրել կոդը]Արհեստական ինտելեկտին վերաբերող երեք փիլիսոփայական հարցեր կան․

- Ընդհանուր արհեստական ինտելեկտը հնարավո՞ր է։ Մեքենան կարո՞ղ է լուծել ցանկացած խնդիր, որը մարդը կարող է լուծել բանականությամբ։ Կամ արդյո՞ք խիստ սահմանափակումներ կան, թե ինչ է կարող անել մեքենան։

- Բանական մեքենաները վտանգավո՞ր են։ Ինչպե՞ս մենք կարող ենք վստահ լինել, որ մեքենաները գործում են և օգտագործվում են էթիկայի սահմաններում։

- Կարո՞ղ է մեքենան ունենալ խելք, գիտակցություն և հոգեվիճակ, նույն իմաստով ինչը մարդն ունի։ Կարո՞ղ է մեքենան լինել զգոն և հետևաբար որոշակի իրավունքներ ունենալ։ Կարո՞ղ է մեքենան միտումնավոր վնաս հասցնել։

Արհեստական ընդհանուր ինտելեկտի սահմանները

[խմբագրել | խմբագրել կոդը]Կարո՞ղ է մեքենան խելացի լինել։ Այն կարո՞ղ է մտածել։

- Հաշվիչ մեքենաները և բանականությունը։ Մեզ պետք չի որոշել, արդյոք մեքենան կարող է "մտածել", մենք պետք է միայն որոշենք, արդյոք մեքենան կարող է գործել նույնքան խելացի, որքան մարդը։ Արհեստական ինտելեկտին վերաբերող փիլիսոփայական խնդիրներին այսպիսի մոտեցումը Թյուրինգի թեստի հիմքն է[296]։

- Դարտմութի առաջարկը։ "Ուսումնառության յուրաքանչյուր ասպեկտ կամ բանականության այլ առանձնահատկություն կարելի է այնքան ճշգրիտ նկարագրել, որ կարելի լինի ստեղծել մեքենա դրա նմանակման համար։" Այս հիպոթեզը տպված էր 1956 թվականի Դարտմութի կոնֆերանսի առաջարկում և արտահայտում է ԱԻ հետազոտողների մեծ մասի տեսակետը[297]։

- Նյուելի և Սայմոնի ֆիզիկական սիմվոլների համակարգի հիպոթեզը։ "Ֆիզիկական սիմվոլների համակարգը ունի ընդհանուր բանական գործողությունների անհրաժեշտ և բավարար միջոցներ։" Նյուելն ու Սայմոնը պնդում են, որ բանականությունը բաղկացած է սիմվոլների նկատմամբ ֆորմալ գործողություններից[298]։ Հյուբերտ Դրեյֆուսը հակառակն էր պնդում, մարդու փորձը ավելի շուտ կախված է անգիտակից բնազդից, քան սիմվոլների գիտակցված մանիպուլյացիայից և իրավիճակի "զգալուց", այլ ոչ հստակ սիմվոլիկ գիտելիքից[299][300]։

- Գյոդելյան փաստարկները։ Ինքը Գյոդելը[301], Ջոն Լուկասը (1961) և Ռոջեր Պենրոուզը (1989-ից ավելի մանրամասն փաստարկներով) առաջ քաշեցին տեխնիկական փաստարկներ, որ մաթեմատիկոսները հետևականորեն տեսնեն իրենց սեփական "Գյոդելի փաստարկների" ճշմարտացիությունը և հետևաբար Թյուրինգի մեքենայից դուրս, հաշվարկային կարողություններ ունեն[302] Այնուամենայնիվ գիտական և մաթեմատիկական համայնքների ներկայիս կոնսենսուսն այն է, որ "Գյոդելյան փաստարկները" անարդյունավետ են[303][304][305]։

- Արհեստական ուղեղի փաստարկը։ Մեքենան կարող է մոդելավորել ուղեղը և քանի որ ուղեղը խելացի է, նմանակված ուղեղը նույնպես պետք է խելացի լինի, ուստի մեքենաները կարող են խելացի լինել։ Հանս Մորավեկը, Ռեյմոնդ Կուրցվեյլը և այլք պնդում ե որ տեխնիկապես հնարավոր է ուղղակի պատճենել ուղեղը ապարատային և ծրագրային ապահովման միջոցով և նման մոդելավորումը ըստ էության նույնն է լինելու[137]։